4足歩行ロボットは野外でも「生存」できるか? 険しい山道や雪が積もる階段など 未知なる環境でも自律歩行に成功【研究紹介】

2022年1月26日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

チューリッヒ工科大学(ETH Zurich)とIntelによる研究チームが開発した「Learning robust perceptive locomotion for quadrupedal robots in the wild」は、外部知覚と内部知覚を組み合わせて、山道や洞窟、雪が積もる階段などの未知なる困難に満ちた実環境でも適宜判断して、自律歩行で高速に乗り越える4足歩行ロボットシステムだ。

先行研究

人や多くの動物は、視覚や嗅覚などの感覚器官で外部を把握する「外受容感覚」と、目を閉じても自分の手や足の位置、それを動かしていると分かる「固有受容感覚」を組み合わせ、これらに基づいて将来の地形を予測し足取りを計画する。これによって、視界が悪く、滑りやすく、柔らかい場所などの困難な環境でも歩行ができる。

昨今の4足歩行ロボットも、急な斜面や段差、隙間のある困難な地形を横断する研究は目覚ましく進展しており、いくつかの商用プラットフォームも展開されている。だが、ロボットに搭載されたセンサーから得られる外部の知覚情報は不完全であり、屋外の実環境では信頼性に欠けることが多い。

例えば、カメラベースの深度センサーは、ステレオマッチングを行うためにテクスチャを必要とする。それゆえに、テクスチャの少ない表面や、表面の一部が露出不足、また露出過多の場合は苦戦し、柔らかい表面と硬い表面に区別ができない。

一方Time-of-flight(ToF)カメラでは、暗い表面を認識できないことが多く、太陽光の下ではノイズが多くなる。深度センサーの測定値から抽出された幾何学的な地形情報を表すには、一般的に標高マップが使用されるが、ロボットの推定姿勢に依存しているため、推定誤差の影響を受ける。このように、屋外の実環境下では思うようなパフォーマンスに達成していないのが現状だ。

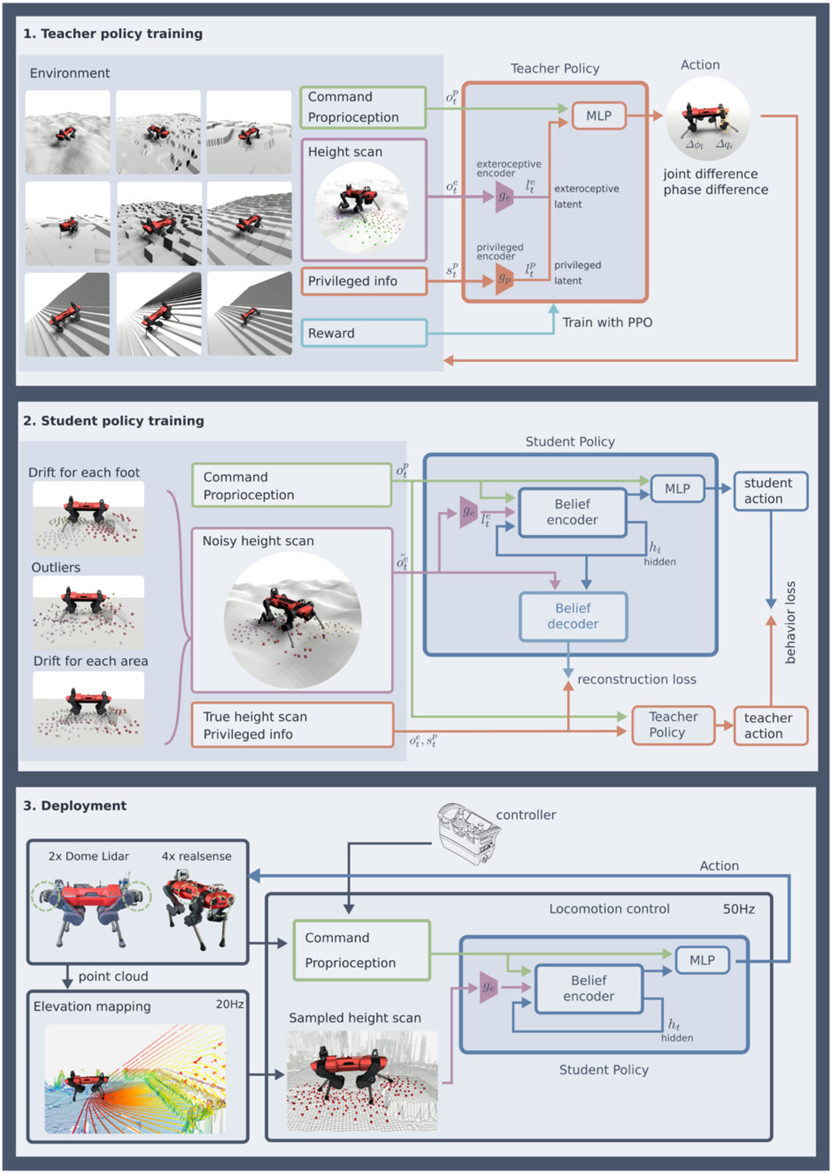

近年、リアルタイム性を損なうことなく、より複雑なダイナミクスを取り入れるために、データ駆動型の手法が導入されている。データ駆動でANYmalを歩行させた研究がその一例だろう。今回はこの「ANYmal」に、ニューラルネットワークをベースにした新しいコントローラーを導入し、外部知覚と内部知覚を組み合わせて 、未知なる環境でも高速に歩行し横断するシステムを提案する。

実験

ロボットは、ANYmal-Cに2つのドーム型LiDARセンサー「Robosense Bpearl」または、4つの深度カメラ「Intel RealSense D435」という2種類のセンサーを搭載して、コントローラーを展開する。ロボットの姿勢を推定し、センサーからの点群データを登録することで、20Hzでロボット中心の2.5Dの標高マップを作成する。

標高マップから各足の周りの高さの測定値をサンプリングし、ポリシーへの外部知覚を形成する。この外部からの入力は、内部知覚データと組み合わされて、ニューラルネットワークに提供され、アクチュエーターのコマンドを生成する。

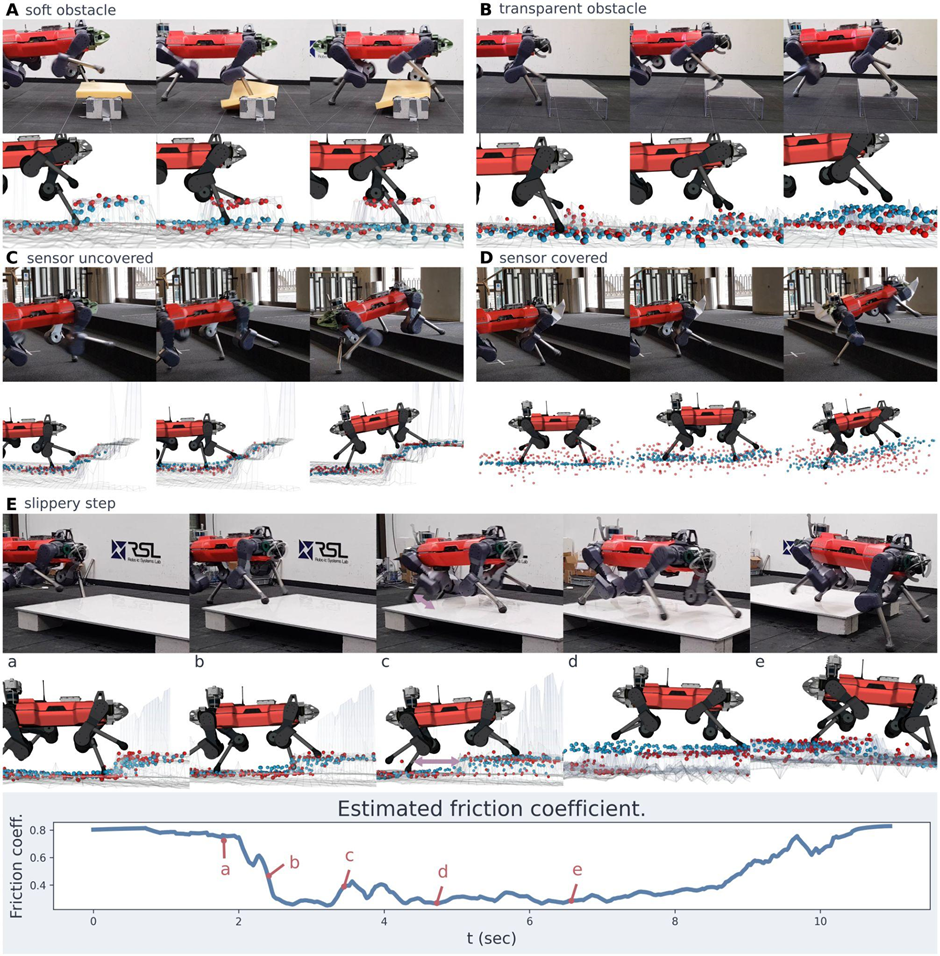

外部知覚が信頼できる場合にはそれを周囲の環境推定に用いて進むが、推定した足場と違った場合には外部知覚が間違っていることを内部知覚が認識して、周囲の環境推定を修正することで転倒を防止する。

例えば、目の前に足を載せる障害物があったとして、一方は踏んでも壊れないが、一方は踏むと割れて壊れるとする。この場合、前者ならそのまま進めば良いが、後者は予測と違うため、地形の推定値を修正する必要がある。本コントローラーはこのような外部知覚と違った場合の内部知覚による下方修正を瞬時に行う。

このように、学習したコントローラーは、外部知覚のスピードと効率性、および内部知覚のロバスト性という2つの長所を兼ね備えている。

本手法は、深度センサーやステレオカメラ、LiDARなどのセンサーを使用しても、微調整なしで動作し、標高マップに含まれる大きなノイズやバイアス、ギャップを処理するように訓練されているため、マッピングに失敗したり、センサーが物理的に壊れたりした場合でも、ロボットは歩行を続けることができる。

実験では、高山、森林、地下、都市など、さまざまな環境でコントローラーを展開した。コントローラーは一貫して安定しており、ANYmalは、急な傾斜、滑りやすい路面、草むら、雪、石段、砂利道などの厳しい自然環境を見事に乗り越え、視界が遮られたり、表面の反射率が高いなどの理由で外部からの認識が妨げられてもロバストに動作した。砂利や砂、ほこり、水、限られた照明などがある地下環境でも、コントローラーは安定して動作した。すべての展開において転倒はゼロであった。

都市部の環境も重要な課題である。ボストンダイナミクス社の最先端の四足歩行ロボット「Spot」では、階段を通過するために、専用のモードを作動させロボットが階段に対して適切な方向を向いていなければならない。これに対し、本コントローラーは、階段用の専用モードを必要とせず、横向き、斜め向き、階段上での振り向きなど、あらゆる方向、あらゆる向きで階段を自然に踏破できる。

さらに、このコントローラーは、異なる課題の組み合わせに対してもロバスト性を発揮した。例えば、階段に積もった雪では段差と滑りやすさが混在している。足が滑って転倒するか、光の反射で混乱して失敗する可能性は高いが、本コントローラーは一貫してロバスト性を維持し、この環境でも転倒せず横断に成功した。

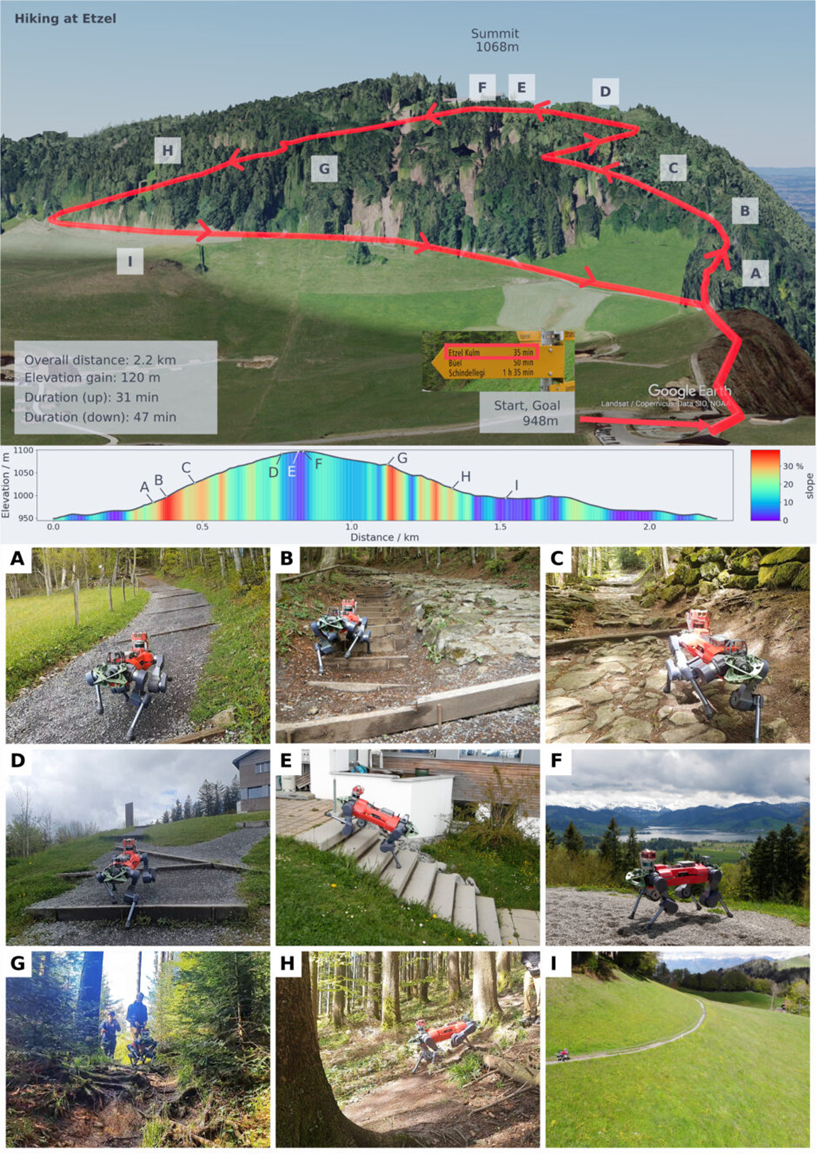

ハイキングで実証実験・結果

このコントローラーのロバスト性をさらに評価するために、スイスのエッツェル山(標高1,098m)でANYmalが1時間のハイキングコースを完走できるかどうかを検証した。ハイキングルートは、全長2.2km、標高差120mで、急な傾斜、高い段差、岩場、滑りやすい地面、木の根などを越えていく必要がある。

結果、ANYmalは31分で山頂に到達でき、これは公式の標識に示されている人間の予想登山時間(35分)よりも速く、78分で全行程を終えることができた。これは、このハイキングを難しいと評価しているハイキングプランナー(76分)とほぼ同じである。

ハイキング中、コントローラーはさまざまな問題に直面した。上り坂では、岩場や濡れた路面で最大38%の傾斜があった。森の中の下り坂では、木の根が複雑な障害物となり、地面は非常に滑りやすくなっていた。また、ロボットの上に植物があると、推定標高マップに深刻なアーチファクトも発生した。このような困難にもかかわらず、 ANYmalは人の助けを借りず、一度も転倒することなくハイキングを終えた。

本コントローラーを導入したANYmalは、2021年9月に開催されたロボット競技「DARPA Subterranean Challenge」に参加し優勝をしている。3つのコース(トンネル、市街地、洞窟)で1700m以上の距離を一度も転倒することなく、自律的かつ高速に動作しミッションをクリアしたわけだ。

これらの結果は、自然界で暮らす野生の狼などが持つ自律性と機動性を兼ね備えたロボットへの道のりにおいて、大きな一歩になった研究と言えるだろう。

Source and Image Credits: Takahiro Miki, Joonho Lee, Jemin Hwangbo, Lorenz Wellhausen, Vladlen Koltun, and Marco Hutter. “Learning robust perceptive locomotion for quadrupedal robots in the wild” SCIENCE ROBOTICS. 19 Jan 2022, Vol 7, Issue 62. DOI: https://www.science.org/doi/10.1126/scirobotics.abk2822

関連記事

青と黄を混ぜると「きちんと」緑色になるお絵かきデジタルツール 油絵や水彩画などのデジタル再現に活用【研究紹介】

相手IDやペアリング、外部機器不要。机上のスマートフォン間だけで「その場限り」の無線データ共有を実現【研究紹介】

「タッチパネル操作時の“遅れ”をなくす」スマホに貼る透明シート 米カーネギーメロン大が開発【研究紹介】

人気記事