「ほぼ実世界。リアルすぎるバーチャル空間を構築」多視点の写真から精密な3Dシーンを作成【研究紹介】

2022年6月27日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

Friedrich-Alexander Universität Erlangen-Nürnbergの研究チームが開発した「ADOP: Approximate Differentiable One-Pixel Point Rendering」は、異なる視点から撮影された複数の画像から高精度なバーチャル3Dシーンを作成する、点群(Point Cloud)ベースの微分可能な深層学習レンダリングパイプラインだ。アーチファクトを抑えた精密な3Dシーンが出力される。

リアルなバーチャル環境を再構築する場合、3次元形状をどのようにエンコードしてメモリに格納するかが重要なポイントとなる。三角メッシュやボクセルグリッドを利用した合成方法、粗い3Dモデルと対象物の画像セットを用いた合成方法、点群を用いた合成方法など、特にポイントラスタライズと深層学習を組み合わせたレンダリングは高い効果を発揮している。

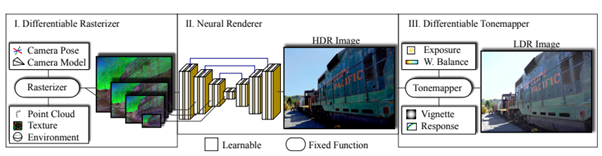

本研究では、このポイントラスタライズと深層学習のパイプラインをベースに、さらに改良を加えた方法を提案する。特に、微分可能なカメラモデルとトーンマッピングを追加し、1ピクセルのポイントラスタライズの空間勾配をより良く近似するための定式化を行った。

システムでは、環境マップ、点群、新規フレームのカメラパラメータを入力として、エンドツーエンドで学習する。テクスチャ化された点群と環境マップで構成されるシーンは、複数の解像度を持つスパースなニューラルイメージのセットにラスタライズされ、DNN(Deep Neural Network)によってHDR画像が再構成される。最後に微分可能なトーンマッピングによって、新しい視点から見たシーンの合成されたLDR画像が出力される。この出力画像は写真などのグランドトゥルースと比較され、その損失はレンダリングパイプラインに逆伝播される。

すべてのステップは微分可能であるため、シーンの全パラメータ(カメラモデル、カメラポーズ、ポイントポジション、ポイントカラー、環境マップ、レンダリングネットワークの重み、カメラ応答関数、画像ごとの露出、画像ごとのホワイトバランスなど)を同時に最適化できる。

これによって出力された3Dシーンは、ちらつきや歪みなどのアーチファクトが少なく、実際のRGM画像と変わらないほど自然で心地よい色の画像に仕上がる。

以下の動画では、300枚の多視点画像と800万以上の点群で新しいビュー合成を表示した出力画像を確認できる。

Source and Image Credits: Rückert, Darius, Linus Franke, and Marc Stamminger. “Adop: Approximate differentiable one-pixel point rendering.” arXiv preprint arXiv:2110.06635 (2021).

関連記事

写真から「立体的なアート作品」をAIが自動作成 米Adobeなどが開発【研究紹介】

動画撮影中の動く顔を「スマートフォンだけ」でアニメ似顔絵風にその場で変える技術【研究紹介】

VR空間に籠もって仕事ができる個室 部屋内で起きる実世界の出来事をリアルタイム再現・後から3D再生可能に【研究紹介】

人気記事