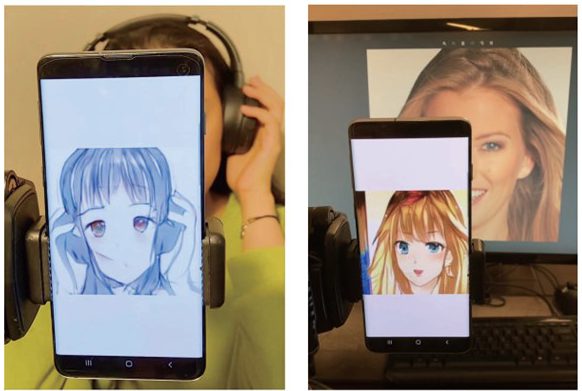

動画撮影中の動く顔を「スマートフォンだけ」でアニメ似顔絵風にその場で変える技術【研究紹介】

2022年6月16日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

米Northeastern University、米College of William & Mary、スイスのETH Zurichによる研究チームが開発した「Real-Time Portrait Stylization on the Edge」は、機械学習を用いて、スマートフォンのカメラで自撮り撮影中の動く顔を追跡し、その場で似顔絵のようなアニメ風にスタイルをリアルタイム変換できる技術だ。これまで困難であった、モバイル上での高品質なスタイル変換を実現する。

顔だけでなく、カメラ内に映る手やヘッドフォン、メガネなどもすべてリアルタイムにスタイル変換され表示される。

課題

近年、撮影している顔をアニメ風のスタイルにリアルタイム変換する機械学習を利用した画像変換モデルが進化している。GAN(Generative Adversarial Network)を用い、細部や多様な特徴などを考慮して高品質に仕上げる。

だが、モバイルデバイスだけで顔のスタイル変換を行うことは依然として困難であり、その理由は2つ挙げられる。第1に、一般的にエンコーダー・デコーダーの設計に従うため、画像変換モデルは高解像度画像において高い計算リソースを必要とする。第2に、GANの学習は難しく、損失発散やモード崩壊に悩まされ不安定である。その結果、これまでの圧縮技術では生成品質を維持することが非常に難しくなる。

開発と評価

そこで今回は、GANのための微分可能なニューラルネット構造探索手法「DARTS」(Differentiable Architecture Search)フレームワークを提案し、この課題に挑戦する。このパイプラインは、十分な構成(チャンネル、特徴量)を持つビルディングブロックのレイテンシを測定し、レイテンシを予測するためにニューラルネットワークを学習させる。これによってGANの探索の難しさを解決し、生成品質を維持したまま、これまでにない圧縮率を達成する。

本フレームワークを評価するために、17,796枚の画像から構成されるFace2animeデータセットなどで実験を行い、生成画像の品質や計算コストにおいて類似モデルと定量的に比較した。その結果、生成モデルは10倍の計算量削減を達成し、生成品質を維持することができた。この大幅な計算量削減により、モバイル環境での高品質なリアルタイムスタイライゼーションが可能となる。

Source and Image Credits: Yanyu Li, Xuan Shen, Geng Yuan, Jiexiong Guan, Wei Niu, Hao Tang, Bin Ren, and Yanzhi Wang.“Real-Time Portrait Stylization on the Edge” https://doi.org/10.48550/arXiv.2206.01244

関連記事

海外メーカー買収で圧倒的シェアを誇るレノボ パソコンの強者が現状突破のために取るネクストアクションとは

映像のみから動けるリアル3Dアバターを作成 服の動きまで精密に再現【研究紹介】

「タッチパネル操作時の“遅れ”をなくす」スマホに貼る透明シート 米カーネギーメロン大が開発【研究紹介】

人気記事