音楽動画からピアノカバーを生成するAI「Pop2Piano」 韓国チームが技術開発【研究紹介】

2022年11月16日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

韓国のRebellions社とソウル大学校の研究チームが発表した論文「Pop2Piano : Pop Audio-based Piano Cover Generation」は、ミュージックビデオなどの音声からピアノカバーを深層学習モデルで自動生成する手法を提案した研究報告だ。メロディとコード抽出モジュールを用いずにポップミュージックの音声から直接ピアノカバーを生成する。

研究背景

ピアノカバーとは、既存の楽曲の音楽的要素をすべてピアノ演奏という形で再現・アレンジした楽曲のことである。ポップミュージックのピアノカバーは、広く親しまれており、音楽教育に利用されたり、Youtubeなどのプラットフォームでピアノカバークリエイターが何百万人も登録されていたりする。

ピアノカバーを作成するためには、元の音声からメロディやコードなどの音楽的要素をすべて認識し、適切なピアノ演奏に再解釈する必要がある。そのため、ピアノカバーの作成はクリエイティブな作業であり、音楽的な知識も必要なため、簡単な作業ではない。中には、聞いただけで弾ける「耳コピ」をする人もいるが、万人向けではない。

また、ピアノカバーはメロディやコードなどの明示的な情報だけでなく、音楽の雰囲気や編曲スタイルなど、さまざまな暗黙の音楽的特徴の影響を受けて作られるため、アレンジャー(編曲家)や編曲方法によって出来上がりに違いが生じる。

一方で、深層学習は高次元の音楽音声データのモデリングに優れた性能を発揮することが報告されており、今回の課題に適している。正確な編曲に自動で変換することが期待できるため、これまでにもありそうなものであるが、ポップスの波形を直接用いたピアノカバーのモデリングに関する深層学習の研究は行われていないのが現状である。これは、ポップミュージックとピアノカバーがペアとなって同期した大規模データセットが存在しないことと、人が深層学習のために十分な量のデータを作成することが現実的に困難なためと思われる。

研究内容

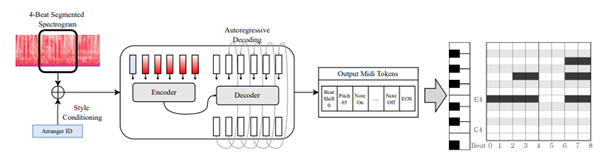

本研究では、ポップミュージックの波形からピアノ演奏(MIDI)を生成するTransformerを用いたピアノカバー生成モデル「Pop2Piano」を提案する。加えて、ポップミュージックとピアノカバーを同期したデータセットを構築する前処理システムを設計した。

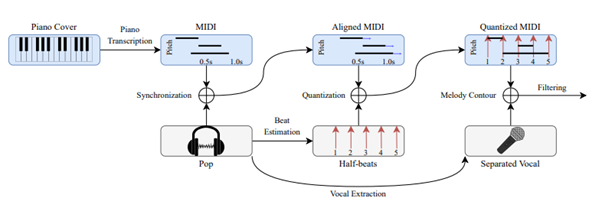

21人のアレンジャーによる5989曲のピアノカバーと、それに対応するポップミュージックをYouTubeで収集し、前処理システムを入れフィルタリングした。その結果、合計4989曲(307時間)が残り、これを学習用として「Piano Cover Synchronized to Pop Audio」 (PSP) と呼ぶデータセットとした。

次に、音声からピアノカバーを生成するTransformerネットワークであるモデルを設計する。これは、メロディやコードの抽出器を用いず、log-Melスペクトログラムをエンコーダの入力として用いて行う。そして、対応する同期したMIDIメッセージをデコーダのターゲットとして使用する。スペクトログラムの最初のフレームの前に、対象となるピアノカバーのアレンジャートークンを埋め込んでいる。

評価

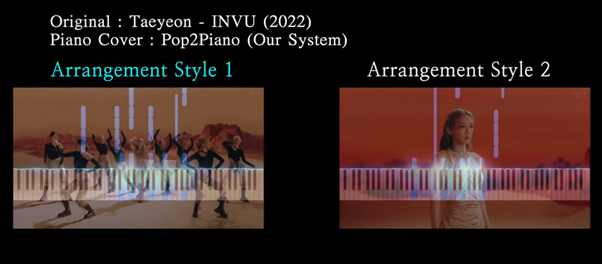

このモデルで実際に出力した結果、もっともらしいピアノカバーを生成することに成功した。また、変換時にアレンジャーのスタイルを選択できるため、気に入ったアレンジャーを選択し編曲することもできる。出力結果は下記の動画で視聴されたい。

研究動画

Source and Image Credits: Choi, Jongho, and Kyogu Lee. “Pop2Piano: Pop Audio-based Piano Cover Generation.” arXiv preprint arXiv:2211.00895 (2022).

関連記事

テキストのみで実写画像の部分的編集ができるモデル「Imagic」 Googleとイスラエルの研究者らが開発【研究紹介】

顔のみをアニメ風にして動画配信。動く人の顔を高品質に漫画化するスタイル転送技術「VToonify」【研究紹介】

画像1枚から永久に続く“空飛ぶシーン”をつくれる技術 Googleなどが開発【研究紹介】

人気記事