実写動画をアニメ映像に変える生成AI「Rerender A Video」 シンガポールの研究者らが開発【研究紹介】

2023年9月20日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

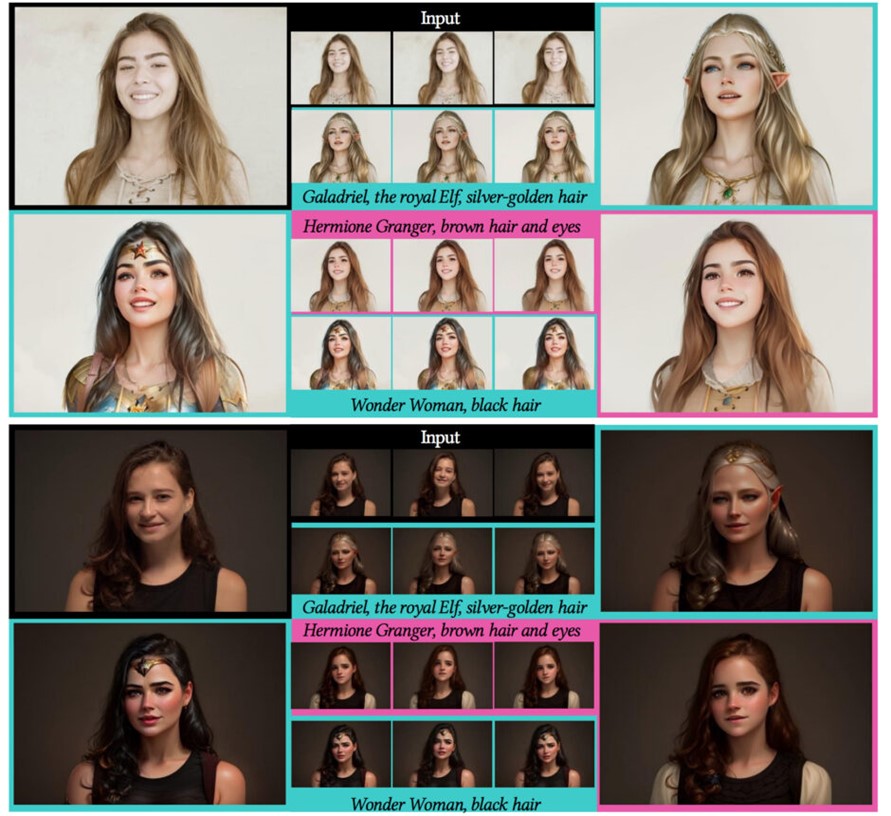

シンガポールの南洋理工大学に所属する研究者らが開発した論文「Rerender A Video: Zero-Shot Text-Guided Video-to-Video Translation」は、画像生成の拡散モデルをビデオの編集に適応させるためのゼロショット・フレームワークを提案した研究報告である。この研究では、テキストプロンプトを使用して既存の実写映像をアニメ風に変換するなどの動画スタイル変換タスクの有効性を示している。

研究背景

近年の研究で、拡散モデルを用いてテキストから高品質な画像を生成する技術が進化してきた。これらの進展を基に、さまざまな応用技術が提案されている。その中には、テキスト指示をもとに動画を生成したり、映像のスタイルを変換するモデルも開発されている。

しかし、これらの先進的な技術を動画生成に適用する際、各フレーム間での画面のちらつきという問題が発生することがある。これは出力結果が滑らかな動画にならないという問題である。

この問題を解決するためのアプローチとして、3つの方法が提案されている。1つ目は、大量の動画データを活用すること。これは大規模な動画データをもとにしたモデルのトレーニングを意味するが、膨大な計算リソースが求められる。2つ目は、単一の動画を用いてモデルを微調整すること。この方法は効果的であるものの、長時間の動画には向かないし、過学習のリスクも存在する。そして3つ目は、学習を必要としないゼロショット法がある。この方法はトレーニングが必要ない上、拡散サンプリングの段階でフレーム間の一貫性を確保する制約を取り入れることができる。有望だが、全体的な見た目は一貫しているものの、細かい部分でのちらつきがまだ発生している。

研究内容

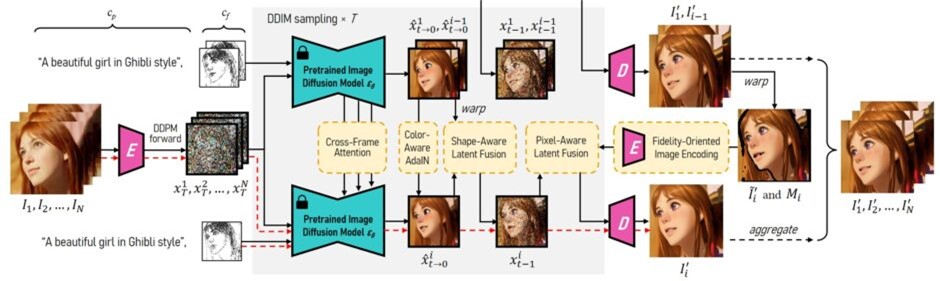

これらの課題を解決するため、本研究では事前に学習された画像生成モデルを用いて、連続する動画フレームの生成のための新しいフレームワークを提案する。特に、テキスト指示に基づき既存の映像をスタイル変換するタスクにおいて、この方法の効果を示す。

具体的には次の通りである。まず、動画中から「キーフレーム」と呼ばれる、重要なシーンや画像を一定間隔を置いて複数選択する。これらのキーフレームを画像生成モデル(Stable Diffusion + ControlNet)を使って希望のスタイルや質感に変換する。この際、「階層的なクロスフレーム制約」という技術を使って、変換されたキーフレームが他のフレームと自然につながるようにしている。

キーフレームが変換できたら、これらのキーフレームを使って動画の残りのフレームも全て変換する。その際に、近くのキーフレームを主に参照するように時間を考慮しながら残りのフレーム全てに伝搬させていく。

評価

提案モデルを評価するため、最近の4つのゼロショット動画変換手法(vid2vid-zero、FateZero、Pix2Video、Text2Video-Zero)と比較した。その結果、提案された手法は、出力の品質、内容とプロンプトの一致、時間的な一貫性の点で明確に優れていることが示された。

Source and Image Credits: Yang, Shuai, Yifan Zhou, Ziwei Liu, and Chen Change Loy. “Rerender A Video: Zero-Shot Text-Guided Video-to-Video Translation.” arXiv preprint arXiv:2306.07954 (2023).

関連記事

【新連載】生成AIで書くソースコードの著作権をどう考えるべきか?元ITエンジニアの弁護士が徹底解説

生成型AIのネクストステージ。セキュリティが保証された小規模な特化型大規模言語モデルの可能性【テッククランチ】

音楽から3Dアバターのダンスを高品質に自動生成するAI スウェーデンの研究者らが技術開発【研究紹介】

人気記事