最新記事公開時にプッシュ通知します

3Dモデルの質感を好きな画風に変えられるスタイル変換モデル NVIDIAなどが開発【研究紹介】

2022年9月13日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

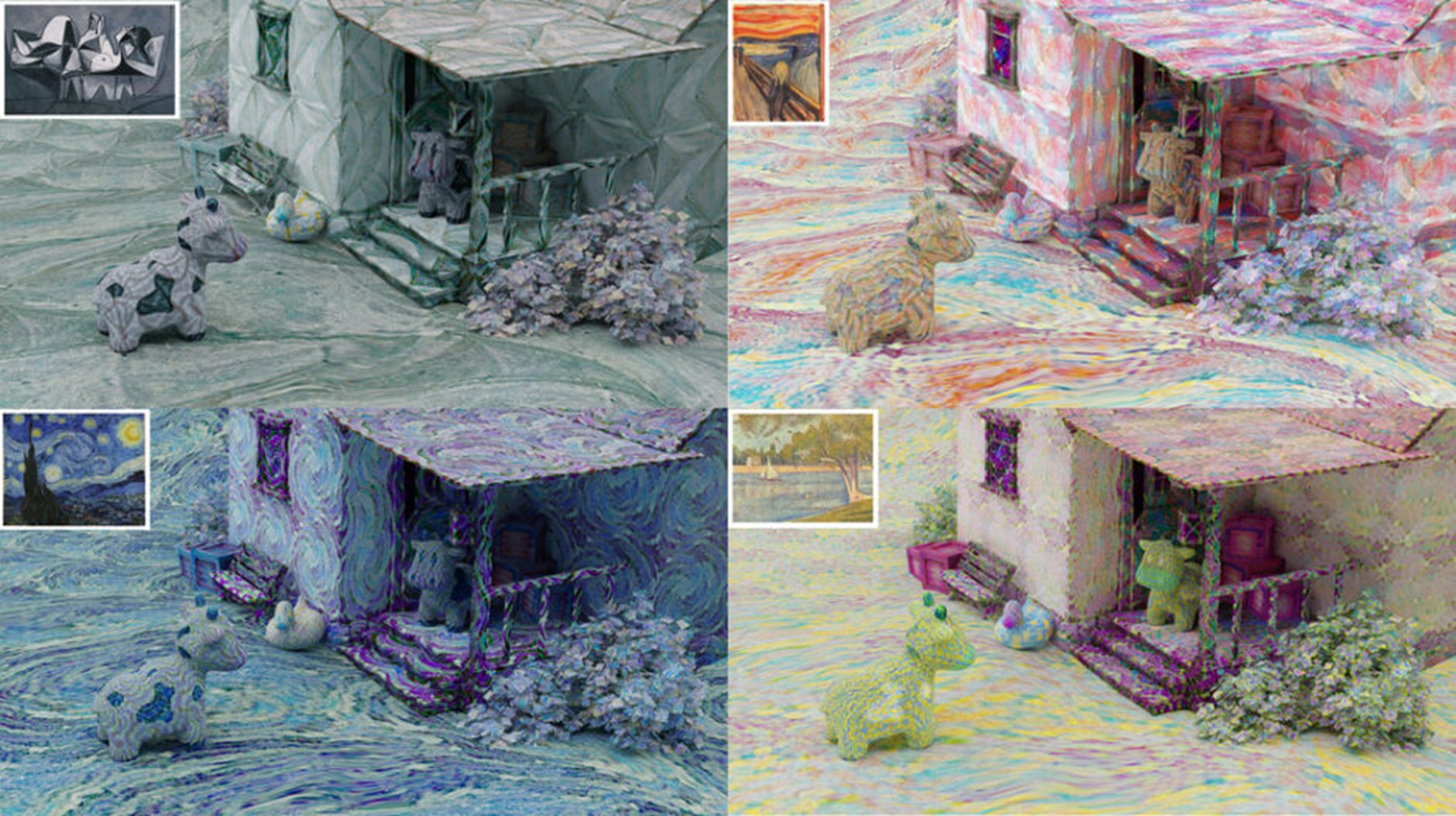

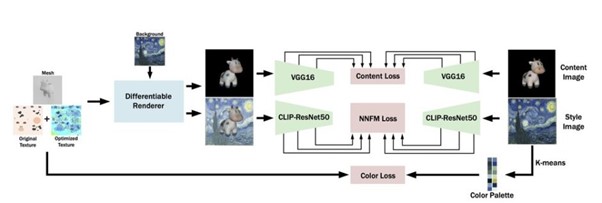

NVIDIAとドイツのSaarland Universityによる研究チームが開発した「CLIP-based Neural Neighbor Style Transfer for 3D Assets」は、ある静止画像のスタイル(画風)を別の3Dオブジェクトの質感に転写させる学習ベースのモデルだ。微分可能なレンダリングと事前学習された深層学習ネットワークを使用し、3Dオブジェクトにおいて高品質なスタイル変換を実現する。

研究背景

近年、画像のスタイルを別の画像に転写するスタイル変換(Style Transfer)技術が発展している。スタイル変換とは、ある画像のスタイル情報を抽出し、他の画像の原型をほぼ残したまま画風や質感だけを転写して合成する手法を指す。

2015年にプレプリントが公開された「Neural style transfer」が登場して以来、スタイル変換のスタイル抽出と合成精度が向上し出力画像も調和した結果が得られるようになった。精度の高さゆえに、任意の画像をある画風に変換する技術が珍しくないものになってきた。関連研究も多く登場している。

他方で、「CLIP」(Contrastive Language-Image Pre-training)がスタイル変換に威力を発揮することが実証されている。テキストから画像を生成する大規模なText-to-Imageモデルが流行しているが、このモデルが流行るきっかけになった1つである「DALL・E」を開発した米OpenAIが同時期に発表したモデルがCLIPである。DALL・Eを支える技術だ。

CLIPとは、インターネット上から収集した画像とその内容を説明するテキスト(キャプション)が組み合わさった4億ペアの事前学習モデルで、画像の分類に利用される。CLIPは事前学習モデルなため、モデル自体はResNetやTransformerが利用される。

先ほどのNeural style transferは、ニューラルネットで学習した特徴空間の距離を最小化するグラム行列で入力画像のスタイルを学習している。しかし、グラム行列はCLIPと相性が悪く適していなかった。

研究過程

そこで本研究では、CLIP(今回はResNet50を使用)と相性の悪いグラム行列の代わりに、特徴空間の距離を最小化する最近傍特徴マッチング(Nearest-neighbor feature matching)という手法を採用した。最近傍特徴マッチングは、新しいデータに対して一番近くの数個の既存データが属するクラスに分類する手法である。

今回はこの最近傍特徴マッチングと、テクスチャの最適化のための微分可能なレンダラーを組み合わせる方法で、非常に高い精度のスタイル変換を出力することに成功した。しかも、2D画像ではなく3Dオブジェクトの質感としてのスタイル変換で実力を見せつけた。

Source and Image Credits: Mishra, Shailesh, and Jonathan Granskog. “CLIP-based Neural Neighbor Style Transfer for 3D Assets.” arXiv preprint arXiv:2208.04370 (2022).

関連記事

AirPodsを聞いている人の横からこっそり自分のイヤホンで盗聴可能な技術 ワイヤレスイヤホンの脆弱性と情報漏洩の脅威を指摘【研究紹介】

1枚の写真から作成する動くメガピクセル頭部アバター。ロシアチームが開発【研究紹介】

「ほぼ実世界。リアルすぎるバーチャル空間を構築」多視点の写真から精密な3Dシーンを作成【研究紹介】

人気記事