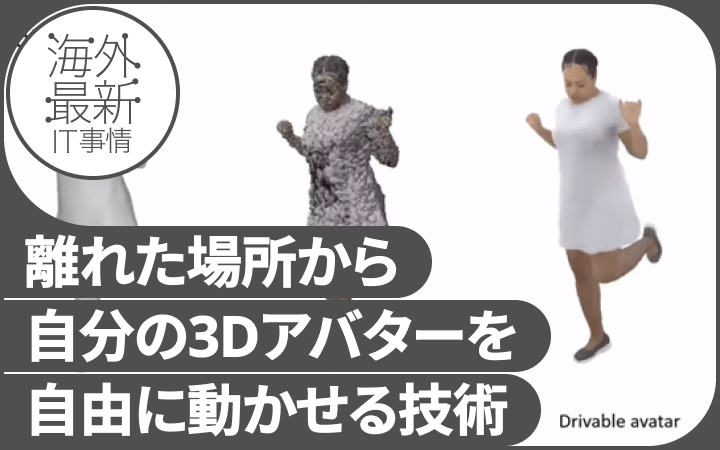

「テレポート会議」ができるレベル 全身の動きを忠実に真似する実写アバターを米Metaが開発【研究紹介】

2022年8月10日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

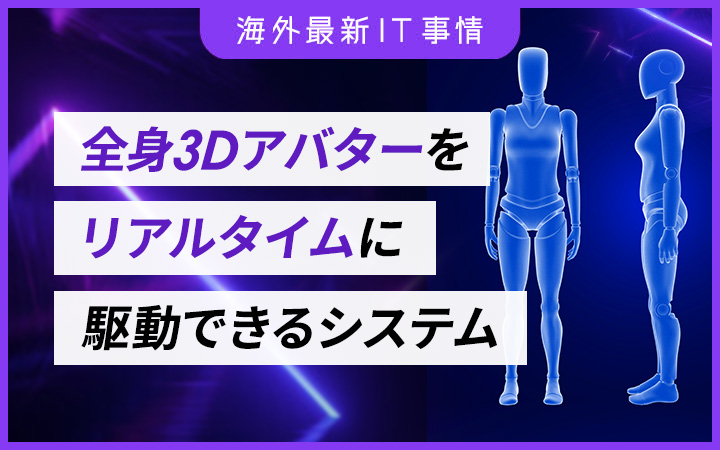

米Meta Reality Labsの研究チームが開発した「Drivable Volumetric Avatars using Texel-Aligned Features」は、衣服を着た全身3Dアバターを作成してリアルタイムに駆動させることができるシステムだ。

ヘッドセットやトラッキングセンサーなどを身に付ける必要がなく、周囲に設置した市販のセンサー数台の前で動作するだけで実現する。その動きは遠隔地に映し出されたリアルアバターで再現され、写実的なテレプレゼンス体験をつくり出す。

研究背景

デフォルメされたアバターがある一方で、本物と見分けが付かないリアリティを追求したアバターがある。このようなリアルアバターは、髪の毛や衣服のシワを含め細部を忠実に再現しなければならない。またリアルアバターの動きをリアルタイムに駆動させるには、より高度な技術が必要となる。

今回研究チームは、この高忠実度の身体モデリングと駆動の2つの課題に挑戦するためのシステム「DVA」(Drivable Volumetric Avatars)を提案する。キャプチャーには高価で大掛かりな機材を用いず、直径4.5mの円の周りに設置した8台の同期・較正されたMicrosoft Azure Kinectを活用する。

研究課題

1つ目の課題である、衣服を着た全身の3Dアバター生成では通常、膨大なポリゴンデータで細部まで滑らかに再現する必要がある。この課題を回避するために研究チームは、「Mixture of Volumetric Primitives」(MVP)を活用する。

MVPとは、単純な立体形状の組み合わせにより髪の毛や顔の表情などの細部が忠実に再現された頭部モデルを表現するシステムで、膨大なポリゴンデータや計算資源を必要としない効率的な手法を指す。この手法を今回は多関節ある全身に適応し、Azure Kinectで得られる疎なマルチビュー画像、体勢、視線方向を入力に、写実的なアバターを生成する。

次に2つ目の課題では、この写実的なアバターをリアルタイムかつ忠実に駆動させる方法を考える。駆動は骨格に基づいて行うが、アバターが動くことで生じる衣服の動きには対応できないため、「Linear Blend Skinning」(LBS)と呼ぶ手法を活用して複雑な衣服の変形を忠実に再現する。

このように生成されたアバターは本物そっくりに表現され、本人の動きそのままがリアルタイムに反映される。このアバターを遠隔で表示すれば、ビデオ会議とは全く違う、その場にいる臨場感でのコミュニケーションが行えるだろう。

評価

既存の手法に対する本システムの有効性を評価するため、新規ビュー合成と身体駆動の2つの観点から最先端の手法と比較した。その結果、どちらの観点からも本手法の方がベースラインよりも鮮明かつアーチファクトが少ない身体モデルの再構成と高い忠実度の駆動を示した。

こちらの動画では、アバターが服のシワなどの局所的な細部を維持したまま、アーチファクトを目立たせることなくアニメーションしている様子を確認できる。

Source and Image Credits: Edoardo Remelli, Timur Bagautdinov, Shunsuke Saito, Chenglei Wu, Tomas Simon, Shih-En Wei, Kaiwen Guo, Zhe Cao, Fabian Prada, Jason Saragih, and Yaser Sheikh. 2022. Drivable Volumetric Avatars using Texel-Aligned Features. In ACM SIGGRAPH 2022 Conference Proceedings (SIGGRAPH ’22). Association for Computing Machinery, New York, NY, USA, Article 56, 1–9. https://doi.org/10.1145/3528233.3530740

関連記事

「スマートフォンを3秒持っているだけで個人認証」。心臓の動きによる「手の震え」を利用【研究紹介】

材料を「空中に浮かせながら」工作するロボット、部品や接着剤の液を音で浮遊させ、接触なしで組み立て可能【研究紹介】

青と黄を混ぜると「きちんと」緑色になるお絵かきデジタルツール 油絵や水彩画などのデジタル再現に活用【研究紹介】

人気記事