サンフランシスコの街を画像からリアルに3D化 Waymoなど「Block-NeRF」開発【研究開発】

2022年2月28日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

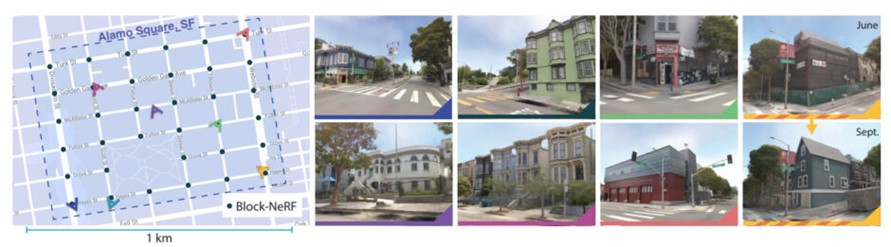

米カリフォルニア大学バークレー校、Waymo、Google Researchによる研究チームは、異なる視点で撮影した街並みの写真から、街全体を写実的な3次元シーンとして再構築する手法「Block-NeRF: Scalable Large Scene Neural View Synthesis」を開発した。行われたデモンストレーションでは、280万枚の異なる画像を使ってサンフランシスコのアラモ・スクエア地区のレンダリングに成功し、その有効性を示した。

先行研究

2020年に発表された合成技術「NeRF」(Neural Radiance Field)、これまで「NeRF」を応用した改良技術が多数発表されてきた。NeRFとは、同じ対象が映っている複数視点の2D画像群から、新たな視点(自由視点)で対象を写実的に3次元で再構築する合成技術(neural rendering)を指す。本手法もNeRFを改良したものとなる。今回は、これまでのような小さな物体ではなく、自律走行や航空測量用に街全体を写実的に3D化する大規模合成に挑戦する。

課題解決

通常、このような大規模環境の3D化だと、天候など同じ環境条件で撮影した大量の写真を必要とする。しかし、大規模となると同じ環境条件の写真を撮影するのは物理的に困難なため、条件が違う写真群を使用せざるをえない。さらに必然的に、一時的な物体(車や歩行者、工事現場など)の存在や外観(天候や時間帯など)にばらつきが生じる。

本手法では、NeRFに外観の埋め込みと学習したポーズの改良を加え、これら写真群の環境変化のばらつきに対応する。また、露出を変更できるように、露出調整機能も追加している。これにより曇りと晴れ、昼と夜など、学習データで観察される異なる環境条件を補完できる。

次の課題は、都市のような大きなシーンを表現しようとすると、1つのNeRFをトレーニングするだけではスケールアップできないことだ。具体的には、レンダリング時間がネットワークのサイズに比例すること、ネットワークが1台の計算機に収まらなくなること、環境の更新や拡張にはネットワーク全体の再トレーニングが必要になることが挙げられる。

これらの課題を解決するために、大規模な環境を個別に学習したBlock-NeRFに分割し、推定時にそれらを動的に組み合わせるレンダリングアプローチを提案する。この方法は、環境全体を再トレーニングしないで済むだけでなく、大規模シーンを分割しBlock-NeRFを独立してモデル化するため、断片的に新しい領域を更新したり導入したりできる。理論上は再構築する範囲を拡大し続けられる。

実証実験

デモンストレーションでは、サンフランシスコのアラモ・スクエア地区を対象に、街並みの画像280万枚を収集し再構築することで、その有効性を実証した。このデモでは交差点ごとにBlock-NeRFを1つ配置した。交差点から次の交差点までの間、交差点自体とそれにつながる道路を75%カバーできたため、隣接する2つのブロックの間には50%のオーバーラップが発生し、ブロック間の調整が容易だったという。

以下の動画では、空や建物が統一された自然でリアルなアラモ・スクエア地区の街並みを確認できる。

Source and Image Credits: Tancik, Matthew, Vincent Casser, Xinchen Yan, Sabeek Pradhan, Ben Mildenhall, Pratul P. Srinivasan, Jonathan T. Barron and Henrik Kretzschmar. “Block-NeRF: Scalable Large Scene Neural View Synthesis.” (2022).

関連記事

YouTubeなど動画内の人を3Dモデルで抜き取る技術 米ワシントン大とGoogle Researchが「HumanNeRF」開発【研究紹介】

VRヘッドセットの脆弱性を指摘 装着者の顔の動きから個人情報を抜き取るシステムを開発【研究紹介】

TikTokの爆発的な拡散力はどこから?AIアルゴリズムと「階層型ユーザープール」で生み出した大ヒットの裏側

人気記事