Bing Chatなどの「生成型検索エンジン」はどれくらい信頼できるか?米スタンフォード大が検証【研究紹介】

2023年4月27日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

米スタンフォード大学に所属する研究者らが発表した論文「Evaluating Verifiability in Generative Search Engines」は、4つの人気の生成型検索エンジンの検索結果がどれだけ信頼できるかを人間による評価で検証した研究報告である。

研究背景

生成型検索エンジンは、入力クエリに対する応答をインライン引用とともに直接生成することで、ユーザーの情報ニーズを満たす。2023年3月、Microsoftは、「プレビューユーザーのおよそ3分の1が毎日(Bing)チャットを使用している」と報告しており、急速にユーザーが増え続けている。

だが、生成型検索エンジンは、人々がオンラインで情報を見つける方法を変える可能性を秘めているが、既存の大規模言語モデルに支えられた生成検索エンジンから生成された応答は、必ずしも正確とは限らないのが現状だ。

その可能性と急速な主流への採用を考えると、これらのシステムを評価して、潜在的な限界をよりよく理解することが重要である。そこで本研究では、4つの人気の生成型検索エンジン(Bing Chat、NeevaAI、perplexity.ai、YouChat )に対し、多数の質疑応答(例えば、過去のGoogle検索のクエリ、Redditで動的に収集されたオープンエンドの質問など)を行い、人間の評価によりどれくらい信用できるかを検証する。

研究内容

評価基準は、次の4つで行う。(1)流暢さ(生成されたテキストが流暢でまとまりがあるかどうか)、(2)知覚された有用性(回答がクエリに対して有用で有益な回答であるかどうか)、(3)引用想起(生成された発言のうち、引用によってサポートされている割合)、(4)引用精度(関連する発言をサポートする生成された引用の割合)。

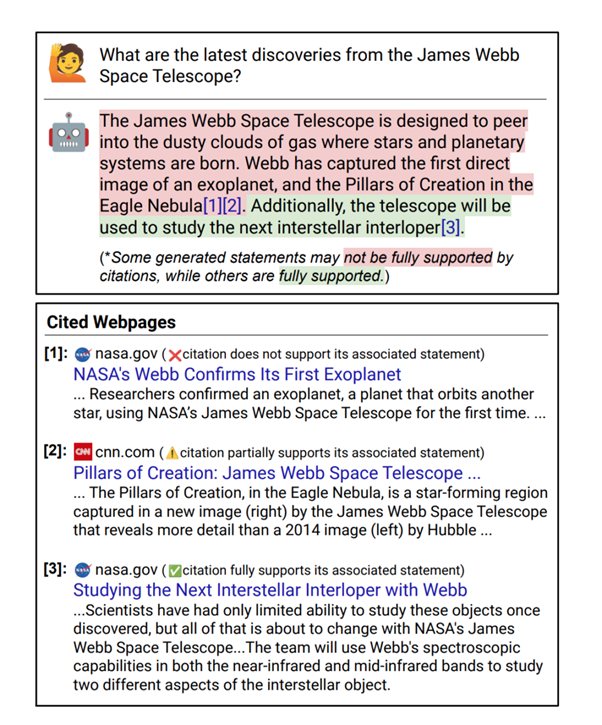

評価した結果、生成型検索エンジンによる回答は、流暢で情報量が多いように見えるが、裏付けのない文章や不正確な引用が頻繁に含まれていることがわかった。平均すると、生成された文章のうち引用によって完全にサポートされているのはわずか51.5%しかなかった。また、引用によってその関連文章をサポートしているのはわずか74.5%だった。

下図では、ジェイムズ・ウェッブ宇宙望遠鏡に関する内容を質問しているが、背景知識がほとんどないユーザーは、生成された回答中の裏付けのない記述に苦労する可能性がある。

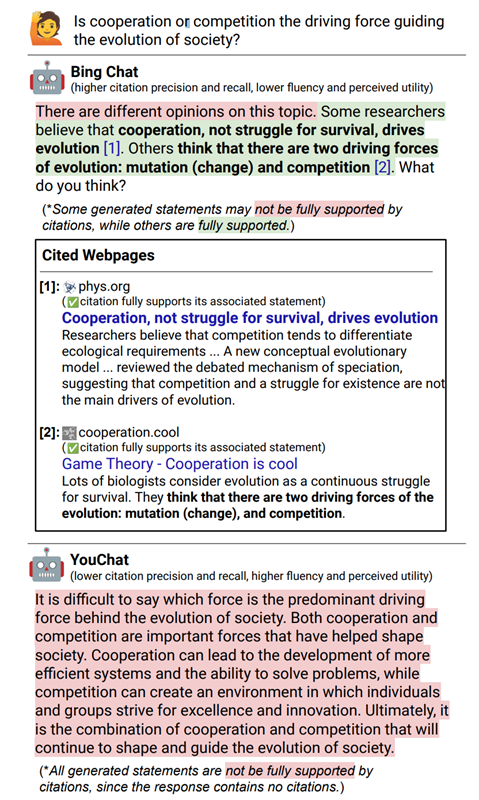

さらに、引用の想起率と精度は、流暢さや有用性の認識と逆相関の関係を持つこともわかった。つまり、より有用に見える回答は、裏付けのない文や不正確な引用が多い傾向にあるということである。このような逆相関は、システムが引用ウェブページをコピーまたは密接に言い換えた場合に発生すると考えられる。

上図の例では、Bing Chatは引用されたウェブページ(太字のテキスト)をコピーしたり、言い換えたりすることで高い引用率と精度を達成しているが、引用された文献はユーザーの入力クエリとはほとんど関係ない。一方、YouChatの回答は、トピックに関連した内容であるが、引用が含まれていない。

研究結果

これらは、現在の生成型検索エンジンがユーザーを欺く可能性が高いことを示唆している。生成型検索エンジンは、すべての回答が引用によって完全にサポートされているわけではなく、すべての引用が関連する文をサポートしているわけでもないため、注意が必要ということである。

これらの結果は、生成型検索エンジンが普及し、すでに数百万人のユーザーを抱えていることを考えると許容できないパフォーマンスと考えられる。この結果と洞察が、信頼できる生成型検索エンジンの開発の動機付けとなり、開発者やユーザーが現在の欠点をよりよく理解するのに役立つことが期待される。

Source and Image Credits: Liu, Nelson F., Tianyi Zhang, and Percy Liang. “Evaluating Verifiability in Generative Search Engines.” arXiv preprint arXiv:2304.09848 (2023).

関連記事

1年の開発を経て、BigScienceのAI言語モデルがついに登場【テッククランチ】

【GPT-4】OpenAI、画像処理もできる最先端の生成型AI「GPT-4」を公開【テッククランチ】

生成型AIの未来を司る「アクティブラーニング」.その活用方法を解説【テッククランチ】

人気記事