【実験】OpenAI、GPTZero…AIが書いた文章はどれぐらい見抜かれる?7つのAI判別ツールを比べてみた【テッククランチ】

2023年2月24日

執筆者

TechCrunchのシニアレポーター、特に人工知能分野に関心を持っている。VentureBeat、Digital Trendsのほか、Android Police、Android Authority、Droid-Life、XDA-Developersなどのガジェットブログに寄稿している。

生成型人工知能(AI)をめぐる熱狂が高まるにつれ、批判的な人々は開発者たちに、有害な影響を緩和するための措置を取るよう求めている。特に文章を生成するAIがかなり注目されているが、これには理由がある。学生が課題の文章を代筆させたり、コンテンツ企業が迷惑メールを書いたり、悪意のある人物が誤情報を流布したりなど、さまざまな可能性が考えられるからだ。

OpenAIは数週間前に圧力に屈し、人間が書いた文章と合成された文章を判別するためのツールをリリースした。しかし、このツールはとりわけ正確なわけではない。OpenAIは、同ツールがAI生成の文章の74%を判別できないと推定している。

AIが生成した文章かどうかを見抜く確実な方法がないため、AI判別サービスという分野が生まれた。米プリンストン大学の学生が開発した「ChatZero」は、トピックモデルを評価する指標「perplexity」などを用いてAIが生成した文章かどうかを判断している。盗作検出ツールの「Turnitin」は独自のAI文章判別ツールを開発した。このほかにも、Googleで検索すると、AIが生成した文章と人間が書いた文章を判別できるとうたうアプリが少なくとも6つはヒットする。

だがこれらのツールは本当に正確だろうか。間違った場合の代償は大きい。大学などでは、判別の失敗で学生が進級できたり、あるいは留年になったりすることがあり得る。ある調査によると、学生の約半数が自宅でのテストやクイズにChatGPTを使ったことがあると答え、半数以上がエッセイの執筆に使ったことがあると認めているという。

比較実験

そこで、AI による文章かどうかを判別するツールが申し分なく機能するかを確認するため、TechCrunchはAIスタートアップのAnthropic(アンソロピック)が開発した「Claude」というChatGPTに似たシステムを使って、さまざまなスタイルの文章を7つ作成した。具体的には、以下のテーマの文章を用意した。

- ・メソアメリカについての百科事典項目

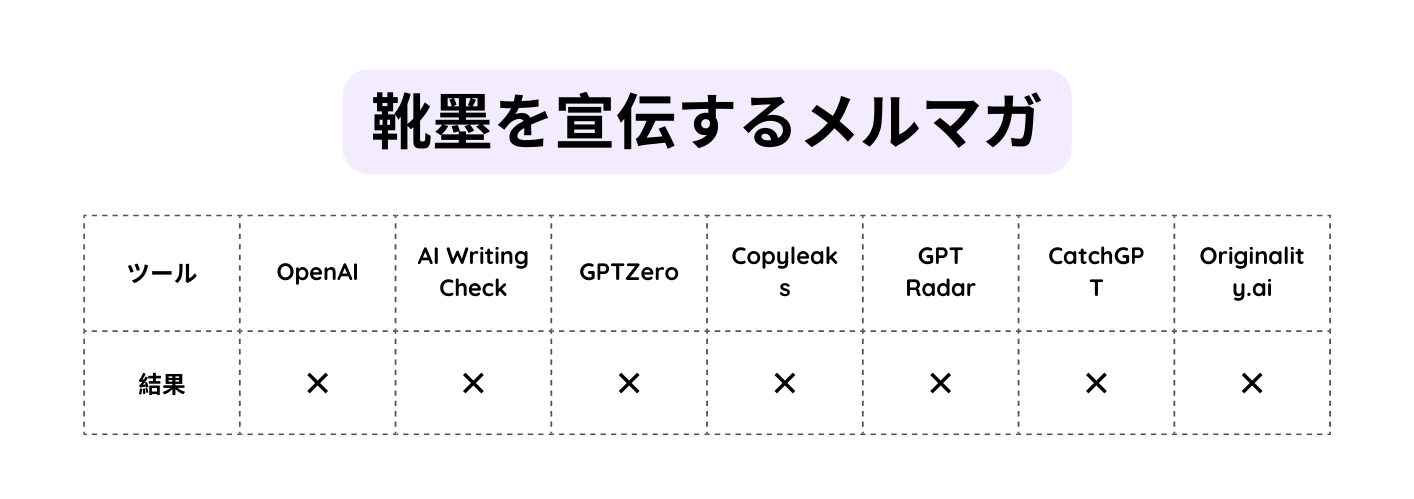

- ・靴墨を宣伝するメルマガ

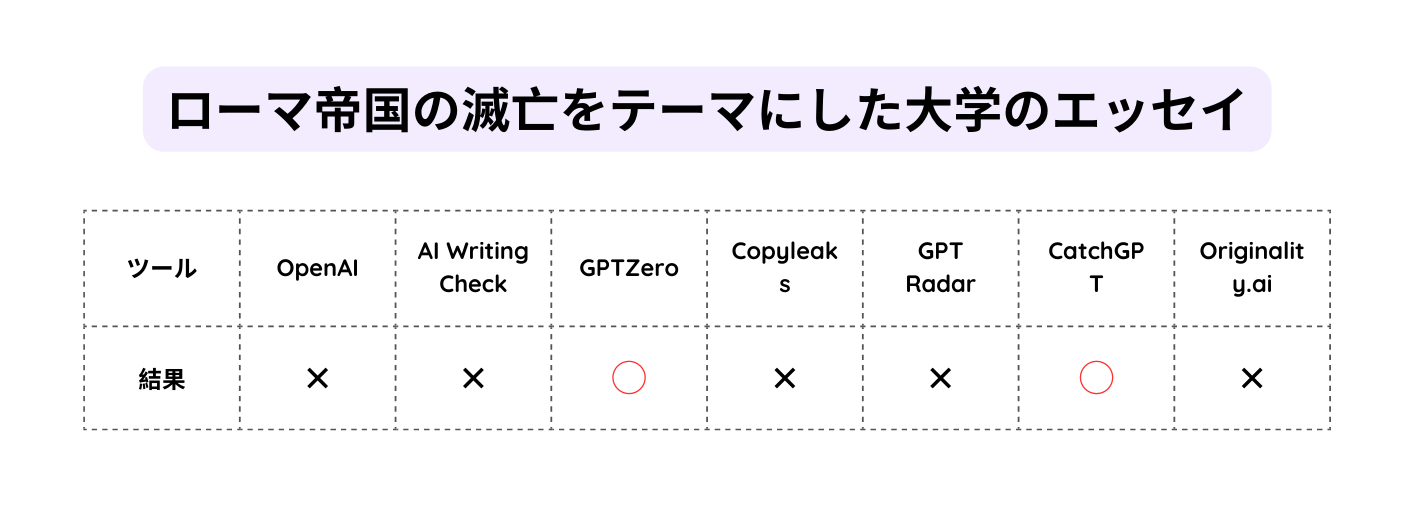

- ・ローマ帝国の滅亡をテーマにした大学のエッセイ

- ・銃規制に関するエッセイの概要

- ・2020年の米国大統領選挙についてのニュース記事

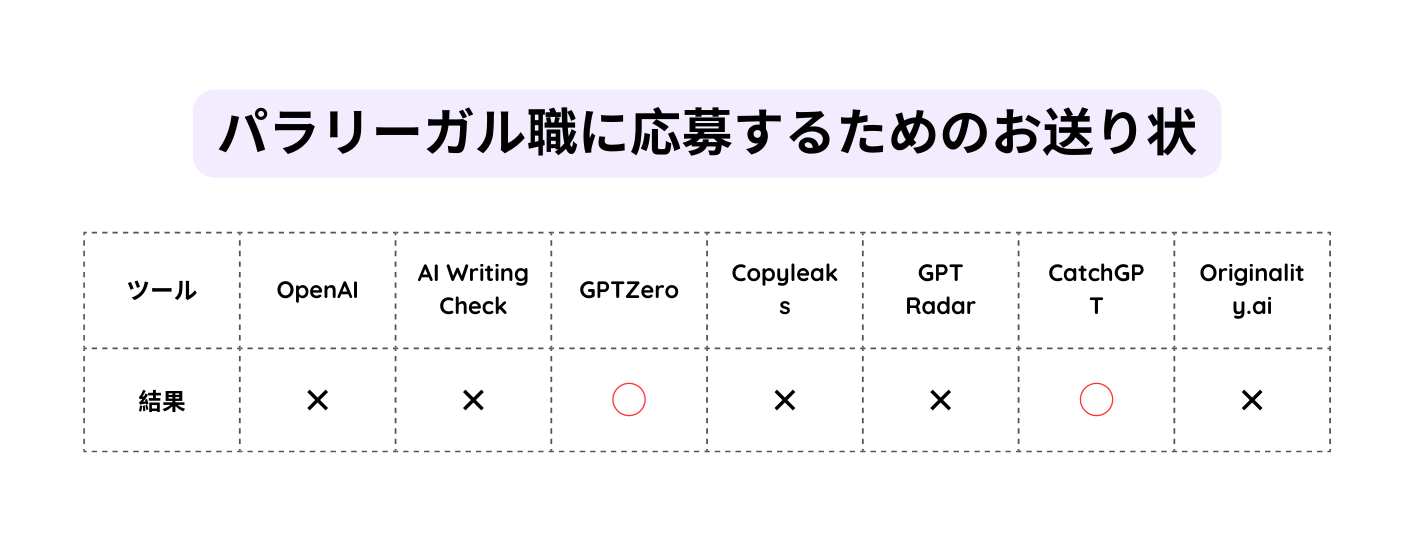

- ・パラリーガル職に応募するためのお送り状

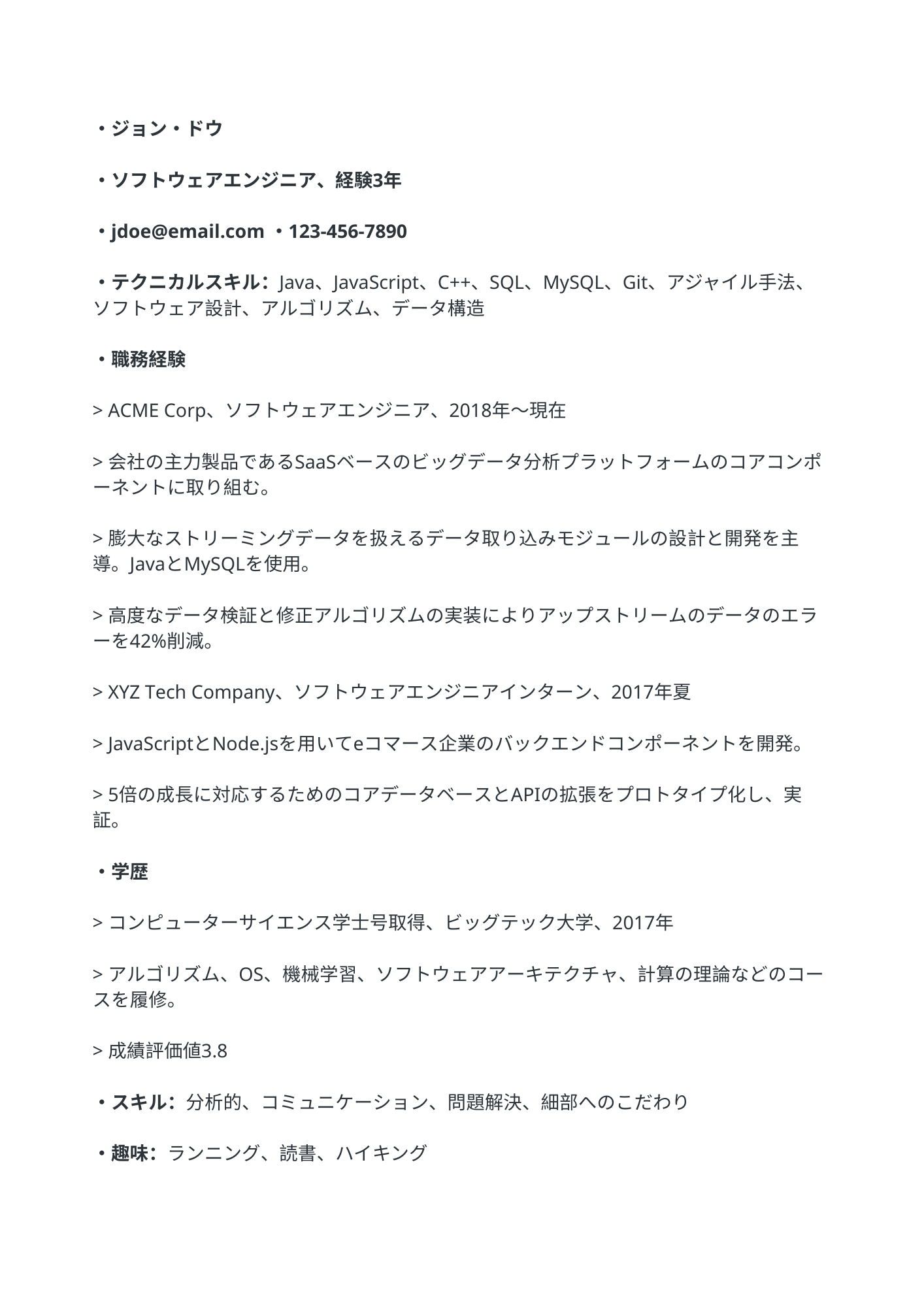

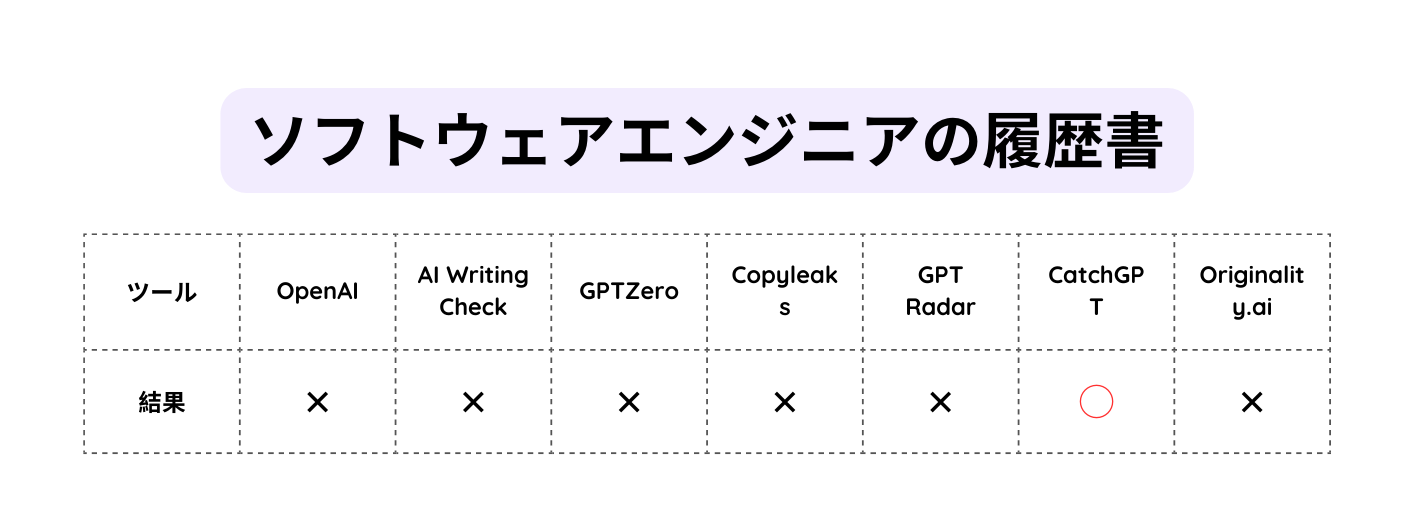

- ・ソフトウェアエンジニアの履歴書

なにか解決策に導けるようなアプローチでないことは認めるこのテストの目的は、1つのAIシステム(Claude)が生成した文章に対するAI文章判別ツールの性能を測定することだ。OpenAIの判別ツール、AI Writing Check、GPTZero、Copyleaks、GPT Radar、CatchGPT、Originality.aiといった、いくつか一般的に人気のある判別ツールをテストした。

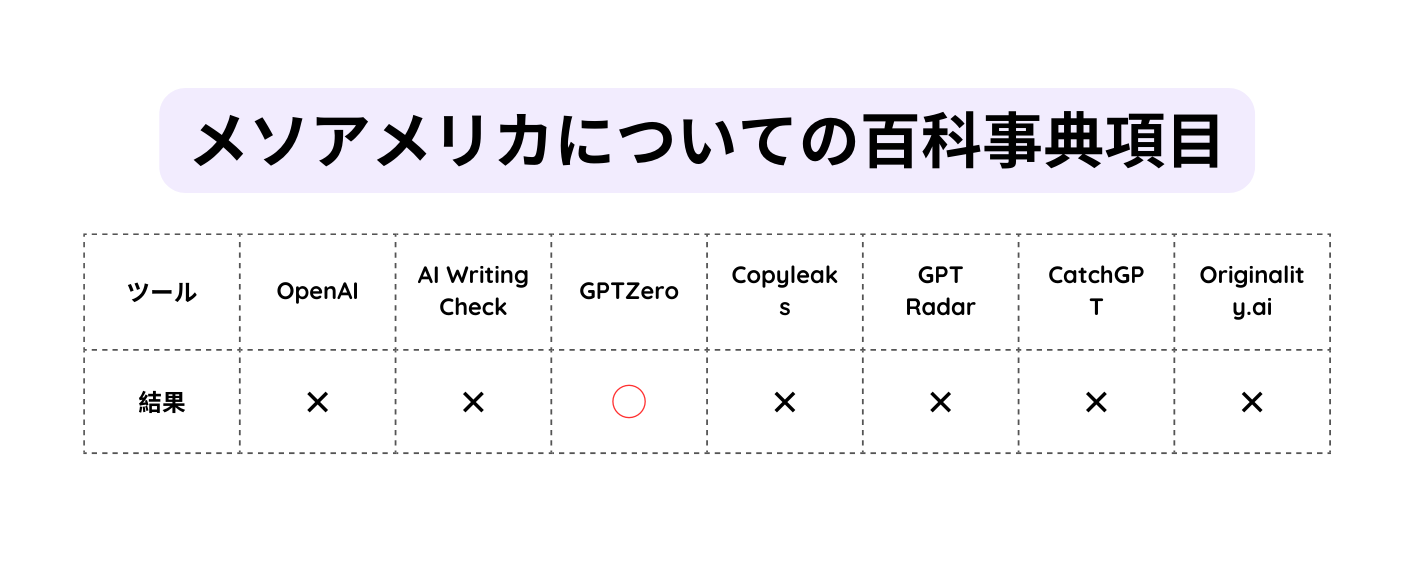

百科事典の項目

Claudeが生成した百科事典の項目は、古代中米文明の興亡と持続的な影響に関する豊富な詳細が盛り込まれ、まるで『ブリタニカ百科事典』から抽出したような出来だ。段落から段落への論の流れもよく、つじつまが合わない表現もあるが、学術出版物に期待するようなものになっている。

このような出来栄えから、我々はこの文章が判別ツールを悩ませるだろうと予想した。実際そうだった。テストした中で、この文章がAIによって生成された可能性があると見破ったのはGPTZeroとOriginality.aiの2つだけだった。OpenAIの判別ツールは当初、確信を持って答えを出せず、Originality.aiでも可能性があるとしたものの、AIが生成した文章である確率を4%と回答した。

CatchGPTはAIが生成した文章を見抜けなかった。

靴墨を宣伝するメルマガ

Claudeが生成したソーシャルメディアコピーは、現実と空想を織り交ぜたユーモラスな内容で、この文章がAIによって生成されたものだとまったくわかりません。商品の価格に言及し、購買行動まで呼びかけている。なんと巧妙なことか。コピーライターの皆さん、ご注意を。

このテキストは信じられないことに、すべての判別ツールを困惑させたのだ。しかし公平に見て百科事典の項目より短かった。判別ツールはパターンが明白な、より長い文章で良いパフォーマンスを発揮する傾向がある。

ローマ帝国の滅亡をテーマにした大学のエッセイ

Claudeは技術的な制約からあまり長いエッセイを書くことができなかったが、それを補うかのように、AIはいくつかの短い段落にできる限り詳細な内容を詰め込んだ。このサンプルは論文ステートメント、結論(特にパンチの効いたものではないにせよ)、レファレンスに歴史的な出来事を上げるなど、授業で書く典型的なエッセイの要素を確かに含んでいる。

メルマガの文面よりもぎこちないとはいえ、自然な文章によりほとんどの判別ツールが再び見抜けなかった。これらのツールに頼ることを期待している教育関係者にとっては悪い兆候だ。盗作を検出するのとは異なり、AIが生成した文章だと見抜くのははるかに精緻さを要するタスクだ。

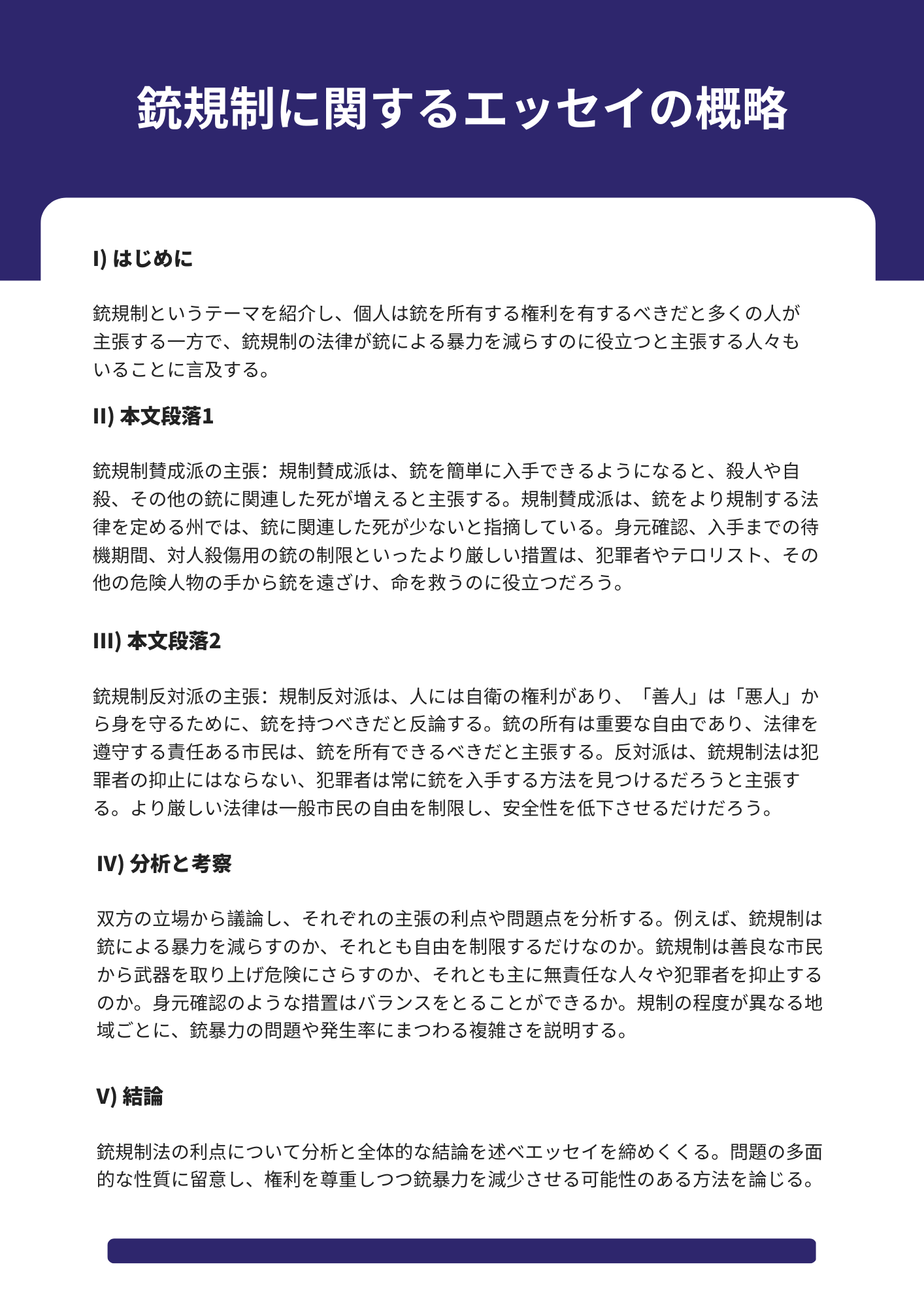

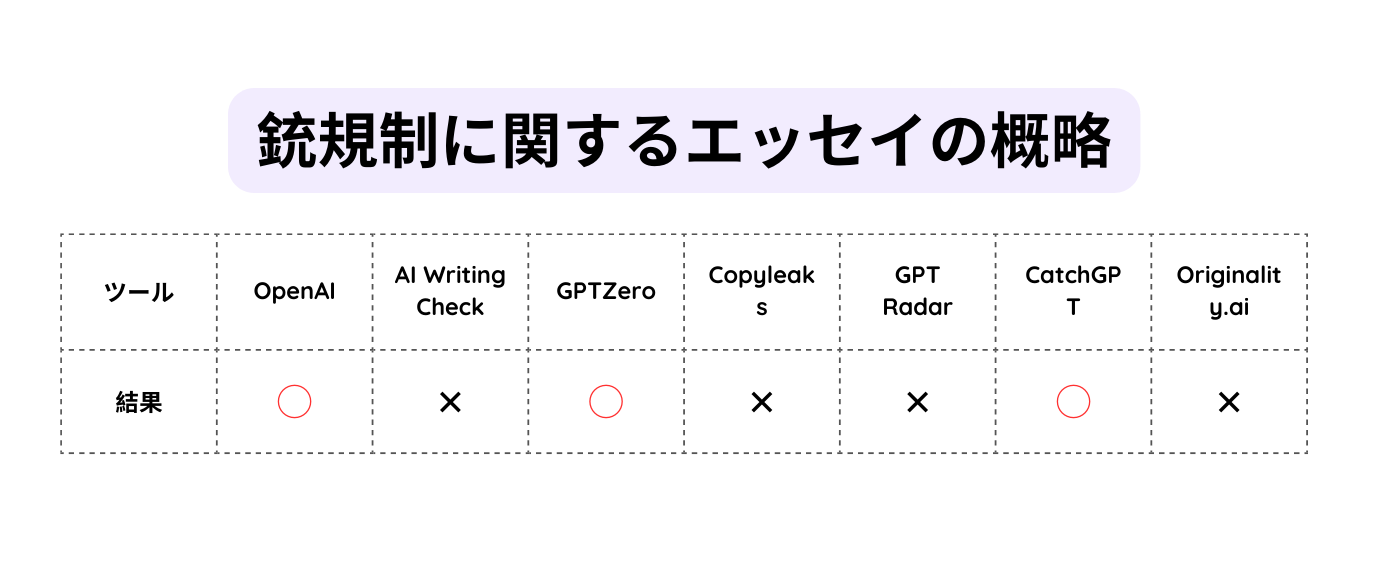

銃規制に関するエッセイの概要

小学生でもエッセイの概略を示すことはできる。AIもそうだ。Claudeは何の苦労もなく銃規制の利点に関する賛否両論のエッセイの概略を作成した。親切にも各段落にラベルを付け(「本文段落」「分析と考察」など)、意見が分かれるテーマについて冷静な論調を維持した。

判別ツールにとって今回はもっと簡単だった。OpenAIの判別ツール、GPTZero、CatchGPTが見抜いた。

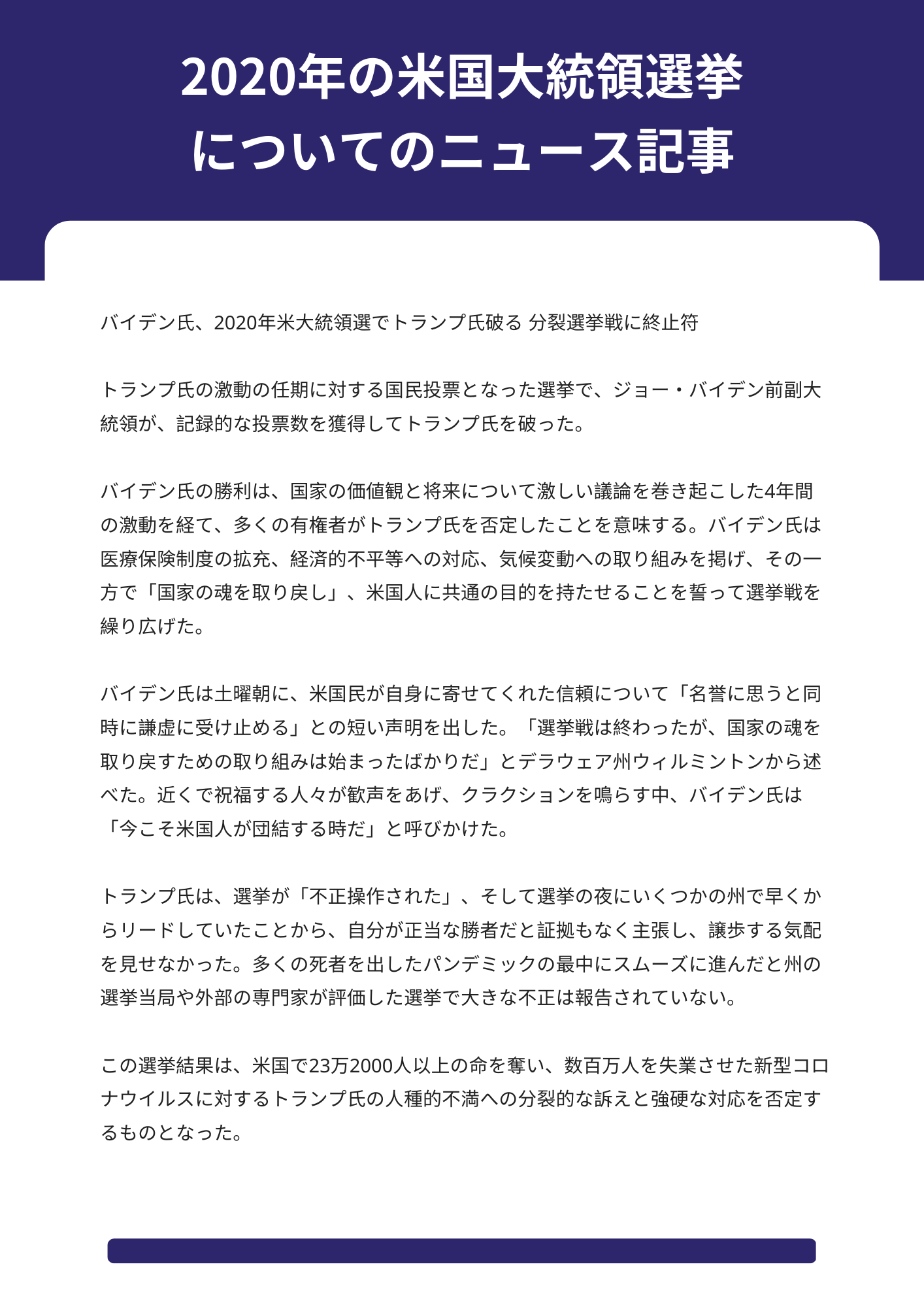

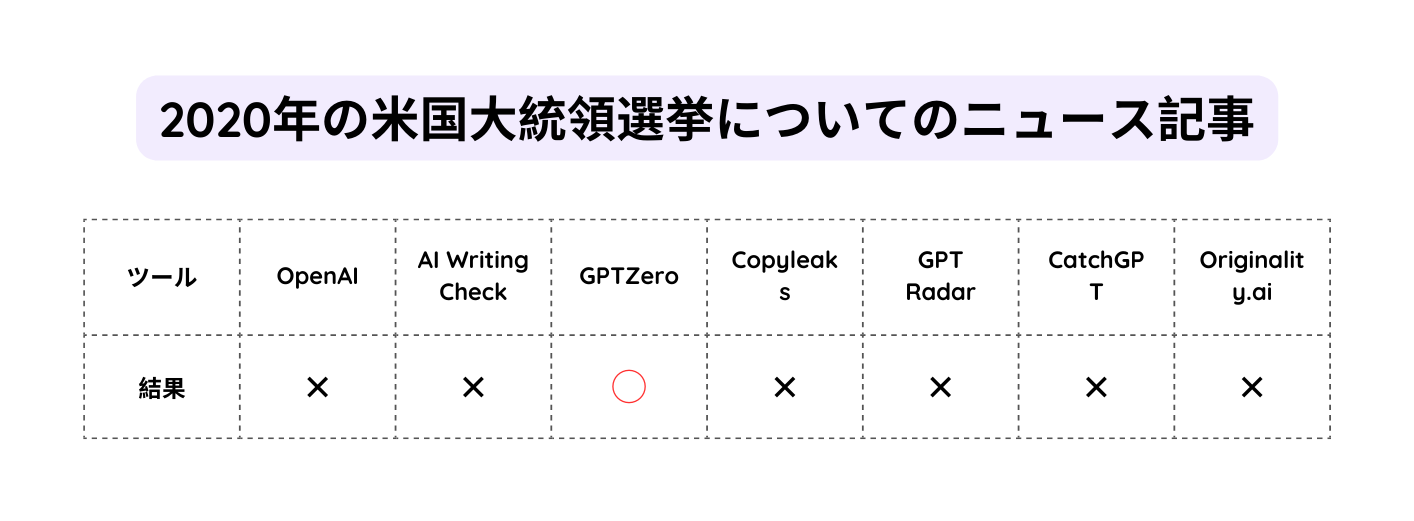

2020年の米国大統領選挙についてのニュース記事

これまでのサンプルと同様、Claudeを使って生成したニュース記事には、明らかに人工的な要素は見当たらない。ほぼ逆ピラミッド型の構成になっていて読みやすい。また、明らかな事実誤認や論理的な矛盾点も見当たらない。

これでは判別ツールが苦戦するのも無理はない。GPTZeroを除いて、どれもこの記事を見抜くことはできなかった。Originality.aiにいたっては、AIが生成したものである可能性は0%と判断した。これはかなりまずい。

パラリーガル職に応募するためのお送り状

Claudeを使って作成したお送り状は、簡潔で余分なところがなく、プロによる文書としての特徴をすべて備えている。架空のパラリーガル職の候補者のスキルを強調し、法律事務所の名前を(少し奇妙だが)つくり出し、WestlawやLexisNexisなどの法律調査ツールにも言及している。

このお送り状はOpenAIの判別ツールを悩ませ、AIが生成したのか人間が作成したのか確信を持って判断できなかった。GPTZeroとCatchGPTはAIが生成した文章だと何とか見抜くことができたが、他のツールはできなかった。

ソフトウェアエンジニアの履歴書

偽のお送り状と偽の履歴書の組み合わせはまさにうってつけだったようだ。Claudeにソフトウェアエンジニアの履歴書を書くように指示したところ、ほぼそのようなものが生成された。この架空の求職者はさまざまなプログラミングスキルを備えているが、特にあり得ないようなスキルは含まれていない。

明らかに、判別ツールも筆者と同意見だ。この偽の履歴書は試したツールの中でこれまで最も信頼性の高かったGPTZeroさえもだましてしまった。

ツールの問題点

これらのテストからどんな結論を引き出せるだろうか。結論からいうと、AI生成の文章を判別するツールは、判別機能が備わっているものの性能がよくない。そのうち、GPTZeroはAIが生成した文章を7回中5回正しく見抜き、唯一安定した性能を発揮した。CatchGPTは7回中4回正しく判別し、2番目に優れた精度だった。一方、OpenAIの判別ツールが見抜けたのは7回中1回で、大差のある3番目だった。それ以外のツールはほとんどさほど機能しなかった。

では、なぜAIによる文章を判別するツールはそれほど信頼できないのか。

判別ツールは基本的に、ウェブ上で公開されている膨大な量のテキストを対象に学習させたAI言語モデルであり、AIによって文章が生成された可能性を予測できるように微調整されたものだ。訓練中に検出ツールは、ウェブサイトやその他のソースから人間が書いた類似の(しかし全く同じではない)文章と比較し、文章の出所を示すパターンを学習しようとする。

しかし問題は、AIが生成する文章の品質は常に向上しており、判別ツールは古い世代の文章をたくさん使って訓練されている可能性が高いことだ。ほぼ継続的に再トレーニングを行わない限り、判別ツールのモデルは時間とともに精度が落ちていくことになる。

となると、AIが生成した文章をベースに文言や構文を修正すれば、どの判別ツールも簡単に回避することができる。AIによる文章生成を使うことを決心した学生や詐欺師にとっては、いたちごっこになる可能性が高い。文章を生成するAIが進歩すれば、判別ツールも進歩する。

判別ツールは特定の状況では役立つかもしれないが、文章がAIによって生成されたかどうかを判断する唯一の証拠としては決して信頼できないだろう。何が言いたいかというと、AIが生成した文章が引き起こしている問題を解決する特効薬はないということだ。かなりの確率で、これからもないだろう。

From TechCrunch. © 2023 Verizon Media. All rights reserved. Used under license.

元記事:Most sites claiming to catch AI-written text fail spectacularly

By:Kyle Wiggers

翻訳:Nariko

関連記事

【ChatGPT】質問に文章で答えるAI「ChatGPT」は何者?TechCrunch記者が聞いてみた【テッククランチ】

「3年前に戻れるなら、同じ意思決定はしない」マネージャーをなくしたサイボウズから学ぶ、フラット型組織でできないこと

【ChatGPT活用事例】一部の投資家は日常業務にChatGPTを活用。ただし、導入に慎重な声も【テッククランチ】

人気記事