最先端技術てんこ盛り!VirtualProduction~カムロ坂スタジオの撮影現場で行われるリアルタイム映像制作の挑戦~

2022年5月9日

株式会社サイバーエージェント AI事業本部 スタジオエンジニア

海木 一佳

2019年新卒入社。カムロ坂スタジオにてモーションキャプチャ、LED、バーチャル合成などの運用に従事。

サイバーエージェントとCyberHuman Productionsが運営するカムロ坂スタジオで繰り広げられる最先端の撮影技術「VirtualProduction」。高精細大型LED、リアルタイム合成システム、トラッキングシステムなどをいち早く導入し、一発勝負が多いライブを成功させ続けている。常に前代未聞の挑戦だらけの中、どのような困難を乗り越えてきたのか。3月24日に開催された「CyberAgent Developer Conference 2022」では、 スタジオエンジニアの海木 一佳氏が最先端の撮影技術と現場での取り組みを紹介する。

第1弾はこちら

17年間の技術負債にどう対処した? 負債の可視化からAWS全面移行まで、事業を支えてきたAmebaシステム刷新プロジェクトを振り返る

- その場でCGの完成絵が見える。カムロ坂スタジオの「VirtualProduction」を解説

- 最新技術に挑み続ける「カムロ坂スタジオ」

- 現場に作業集中、技術人材不足… 現場を安定・拡大させるオペレーション改善の工夫

- クロマキー方式とLED方式の相互補完。 最先端技術で実現するライティングの簡易化

その場でCGの完成絵が見える。カムロ坂スタジオの「VirtualProduction」を解説

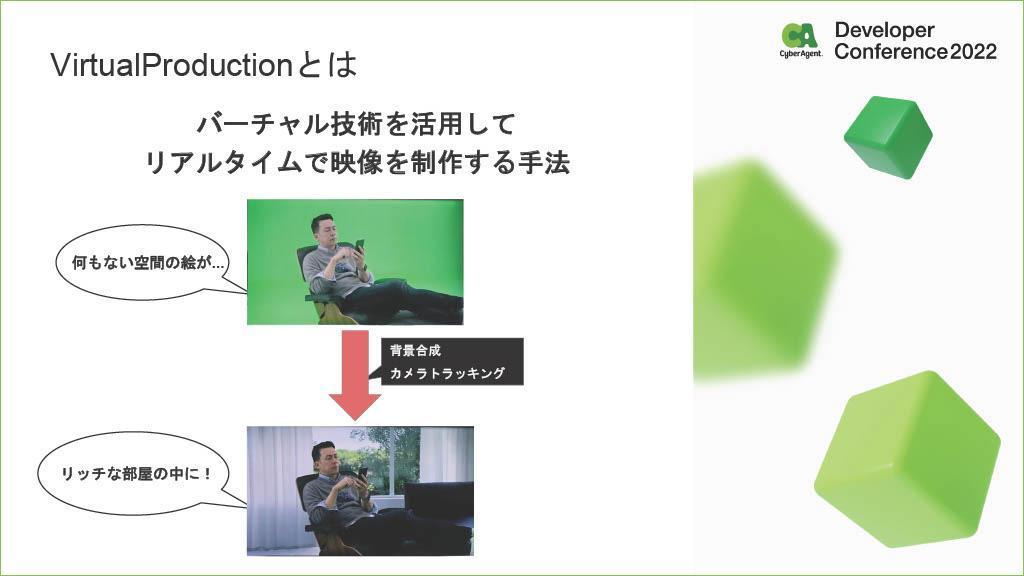

VirtualProductionとは、CGやトラッキングなどのバーチャル技術を駆使して、リアルタイムで映像制作する手法。実現する手段として、クロマキーやLEDディスプレイなどを活用したCG背景合成や、カメラトラッキングによるCGの追従などがある。

クロマキーとは、緑や青などの均質色の背景をバックに人物を撮影し、背景に別の映像をはめこむ合成技術である。一方、LEDディスプレイを活用する手法は、映像を背景に置きながら撮影するので、撮影される演者がイメージしやすく、編集もしやすい。

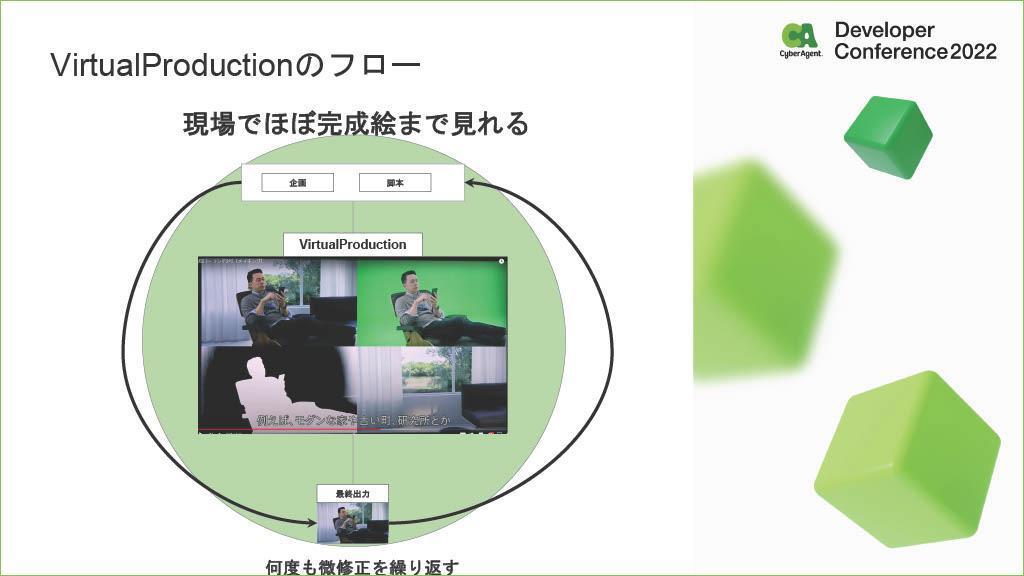

「さらにVirtualProductionのフローであれば、現場で合成まで行うことができ、その場で7~8割くらい完成した状態で、CG合成を確認して使うことができます」

サイバーエージェントでは、主に広告クリエイティブにおいてVirtualProductionを活用している。進化が速い広告領域において、柔軟性やスピード感をもってハイクオリティーのクリエイティブを追究できるというわけだ。

また、コロナ禍において、これまでの撮影手法で撮影することが難しい状況に陥ったのも要因の一つ。オンラインライブ、オンラインコミュニケーションを盛り上げる手法や技術がこの1~2年で急速に進化したと、海木氏は語る。

最新技術に挑み続ける「カムロ坂スタジオ」

カムロ坂スタジオは、サイバーエージェントがVirtualProductionを活用してバーチャル撮影を行っているスタジオである。このカムロ坂スタジオでは、様々な最先端技術を使ってクリエイティブを生み出している。その事例も紹介された。

例えば、以下のスライド画像は、リアルタイムで中継されているサイバーエージェントの社内表彰イベント「CA BASE AWARD」の映像である。CEOの藤田晋氏が巨大な空間の中に立っており、背景には、表彰者を称える言葉や表彰者の情報や、Zoomで中継を繋いだ映像なども流れた。

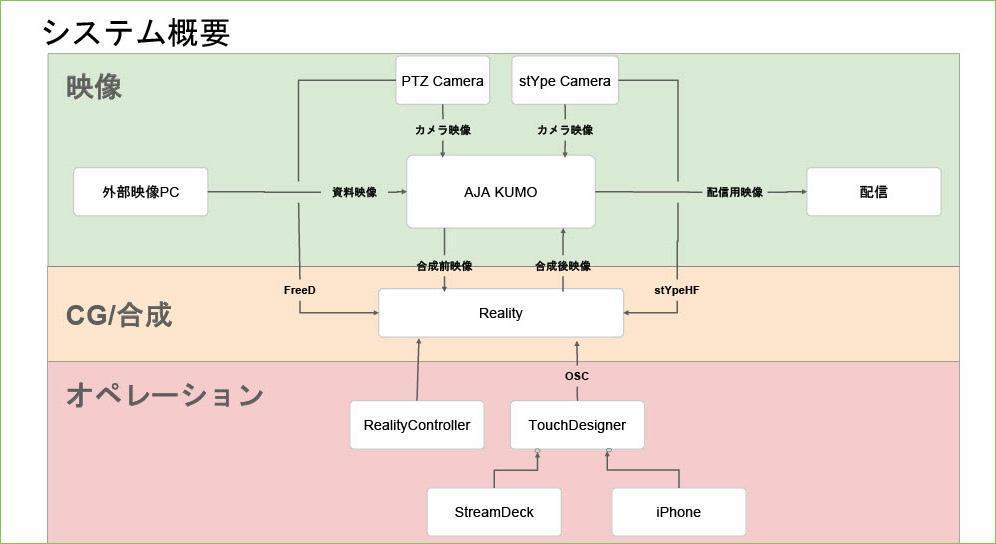

このバーチャル撮影システムに関しては、PTZ Camera、stYpe Cameraといったトラッキング付きのARカメラを使用している。

それらの映像をAJA KUMOというハブに流し込み、合成前の映像としてRealityという合成システムに入れ込んでいく。CG合成のオペレーションは、RealityControllerというアプリ、それからサイバーエージェントがTouchDesignerを用いて独自開発したソフトウェアを使って行われている。

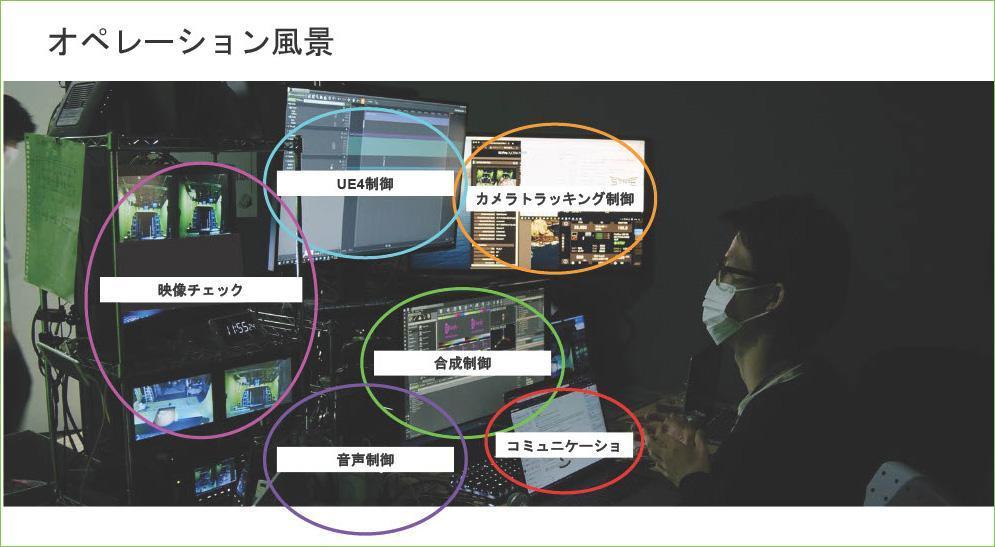

これらを一つの席から、TeamViewerというアプリを利用してあらゆるデバイスに対して、オペレーションを可能にしている。

「VirtualProductionはCGや合成、カメラトラッキングなど、映像のあらゆる技術を複合した技術。一つ問題が起きたときに、どこが問題なのか判定することは非常に難しいのですが、こうやって一気に監視することによって、問題特定が非常に速くできています」

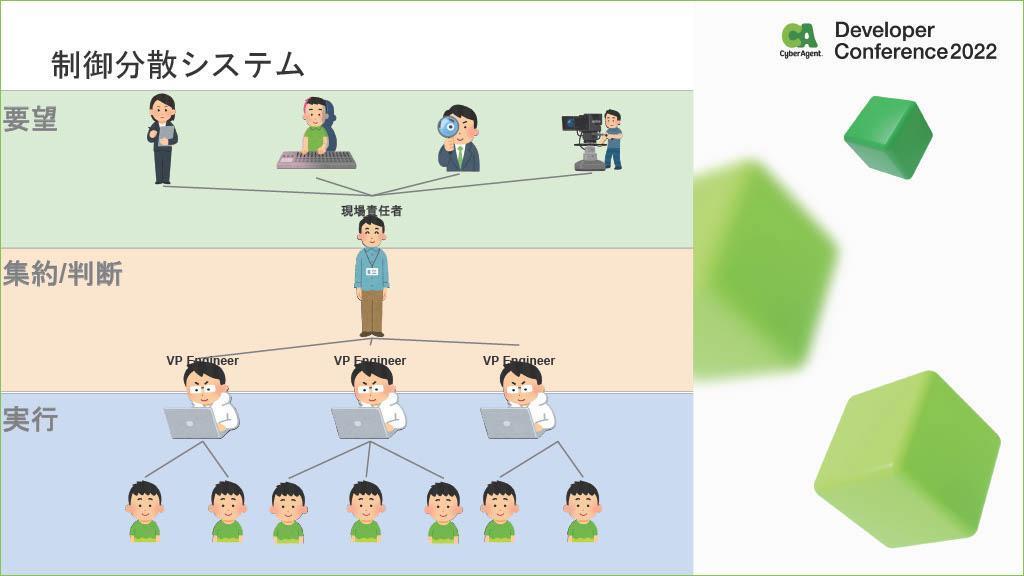

現場に作業集中、技術人材不足… 現場を安定・拡大させるオペレーション改善の工夫

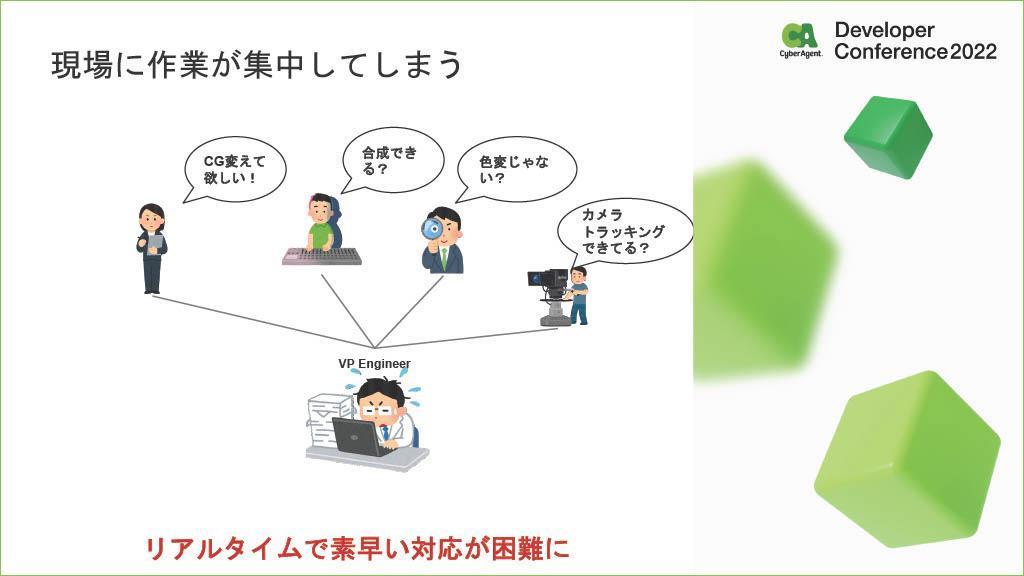

しかし、VirtualProductionをスタートした際にも問題が起きた。現場に作業が集中してしまうことだった。VirtualProductionの特徴でもある、現場でリアルタイムの調整が可能なため、現場に作業が集中してしまい、仕事がパンクするという問題があった。

現場のオペレーションを改善するため、限られた時間でできるだけ多く要望に応える必要があった。

「そこで非常に役に立っているのが、RealityControllerに含まれるRealityNodeというアプリケーションです。これはRealityで動いているプロジェクトに対して、ノードベースのGUIで合成やCGの調整、カラーコレクションなど、あらゆるバーチャルプロダクション必要になる制御ロジックを組むことができます」

さらに一つのプロジェクトに対して、複数のPCで複数の人で同時に制御することも可能だという。RealityControllerには、RealityActionというボタン式でリアルタイム制御できる便利なアプリもある。

「これにより、前の作業が終わるまで次の作業に進めないというこれまでの課題が改善され、同時に進行している一つのプロジェクトに対して、1人が合成、1人がCG調整、1人がカラコレというように、複数の問題を対応することが可能になりました」

課題はまだあった。Realityというソフトを導入したのは、日本国内でサイバーエージェントが初めてだ。習得者数が非常に少なく、癖の強いソフトウェアだということである。ソフトウェアを習得しないと使えないとなると、なかなか現場にオペレーションが浸透しなかった。

そこで海木氏らは、操作を簡略化するためのツールを複数開発した。

・「OSC Hub」

様々なハードウェアからの入力を、OSCを通して別のソフトウェアやハードウェアへ飛ばすことができるというものだ。これで任意のハードウェアを制御することが可能で、オペレーションを簡易化している。「OSC Hub」を活かして、これまで実現できなかった背景のCGとスタジオ照明を同時に切り替えるなど、ソフトとハードを組み合わせた演出も可能になった。

・「BG Key Watcher」

ソフトウェアのバックグラウンドでキーを入力してくれる「BG Key Watcher」。キーボードの入力を行うときに、ハードウェアからの信号がフォアグラウンドのアプリケーションにしか作用しないという問題を解決するものである。

このアプリの開発に関してはWindows32APIを使用し、キーの入力を監視しており、UIに関してはC# Formsアプリで作成している。

さらに、これらのツールを現場の方が普段から愛用している機材に組み込むことで、現場で外注のスタッフとともに作業する際も、滞りなくオペレーションを回すことが可能になった。

こうして本来対応しなかったハードウェア、ソフトウェアに対しても、OSCを経由して操作できることにより、新たな表現を開拓することができるようになった。VirtualProductionのエンジニアはより幅広い業務に対応することが可能となり、作業をスムーズに行うフローを実現できた。

続いて、LED STUDIOについても紹介された。カムロ坂スタジオにはリアルタイムのクロマキー合成システムだけではなく、巨大なLEDに対して撮影するVirtualProductionシステムがある。

LEDを使ったVirtualProductionでは、映像の中の人の動きとCGの視差をなくす技術が活用されている。CGのレンダリングに関してはUnrealEngine4、LEDの同期にはnDisplayを使っている。また、カメラのトラッキングに関しては、RedSpyというARトラッキングシステムを使い、そのトラッキング情報をCGカメラと同期することで実現している。

クロマキー方式とLED方式の相互補完。 最先端技術で実現するライティングの簡易化

もう一つ現場を安定・拡大させる取り組みとして、ライティングの簡易化についても紹介された。例えば、CGに連動して自動で照明が切り替わるシステムについては、DMX Unreal EngineのDMX PluginのPixel Mappingを使って、リアルの照明と同期するようにしている。

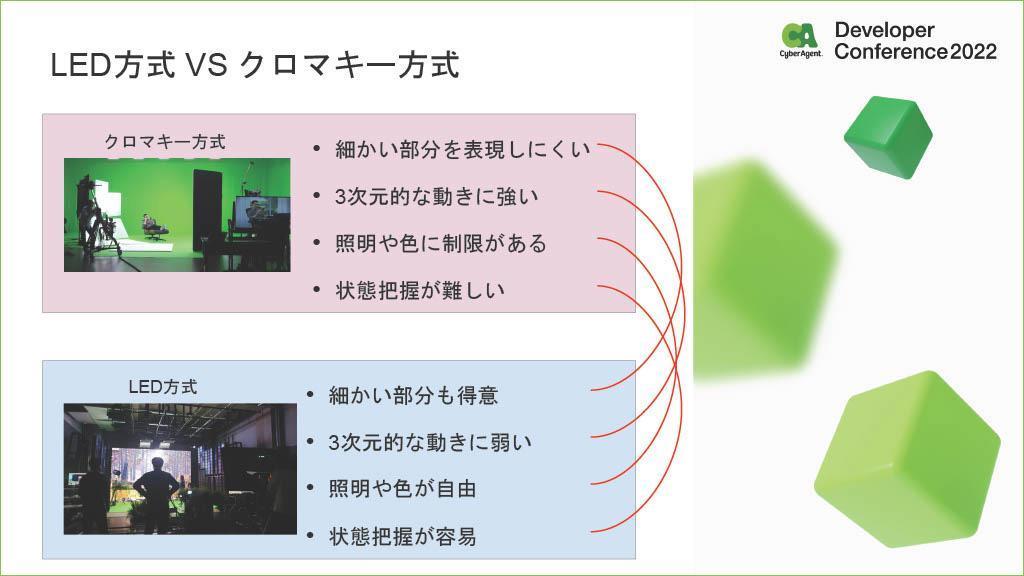

カムロ坂スタジオの強みとして、クロマキー方式のVirtualProductionとLED方式のVirtualProductionを持っていることが挙げられる。海木氏はそれぞれのメリット、デメリットを説明し、お互いの弱点を補完できることが、2つの方式を持つ強みだと語った。

例えば、クロマキー方式は細かい部分を表現しにくいが、三次元的な動きに強い。対してLED方式は、細かい部分は得意だけど三次元的な動きに弱い。相互補完性がある2つの方式を組み合わせることで、あらゆる場面に対して対応することができるというわけだ。

続いて、フルCGでのバーチャルプロダクションの作成例が紹介された。

こちらのボディモーションの収録において、MVNのスーツを利用したという。スタジオ内に置かれている機材などのノイズに対して非常に強く、厳しい環境でも動いてくれるというメリットが紹介された。

そして、カメラトラッキングに関しては、OptiTrackを利用している。実はカメラのモーションキャプチャの撮影とカメラトラッキングに関しては別々にやっており、先にモーションキャプチャの撮影を終えてから、カメラトラッキングを行っているとのこと。

実際にプロのカメラマンにバーチャルカメラで撮影してもらうことで、臨場感溢れるカメラアングルが現場で生まれてとても良かったそうだ。

「UE4 Virtual Cameraという機能を使えば、リアルタイムでストリーミングした映像を見ることが可能となり、カメラマンがどんな映像を撮れているかを確認することができます」

モーションストリーミングについては、MotionBuilderを使っている。リアルタイムの補正や、キャラクターとカメラの動きを作ることができるからだという。

去年開催されたイベント「CA BASE NEXT」では、リアルタイムでクロマキー合成に使われたRealityという合成システムでセルルックなキャラクターと文字を合成、背景にはLEDを使っている。

「背景にCGを出すのはARだと非常に難しいのですが、LEDでは物理的に置くことができます。リアルの人物をCGで挟むことで、CGキャラクターたちの存在感を高めることができました。これらは全部常設の機材で行っています」

参考:不確実な時代の生存戦略を、3DCG化したバーチャル社員が聞いちゃうよ! | CA BASE NEXT

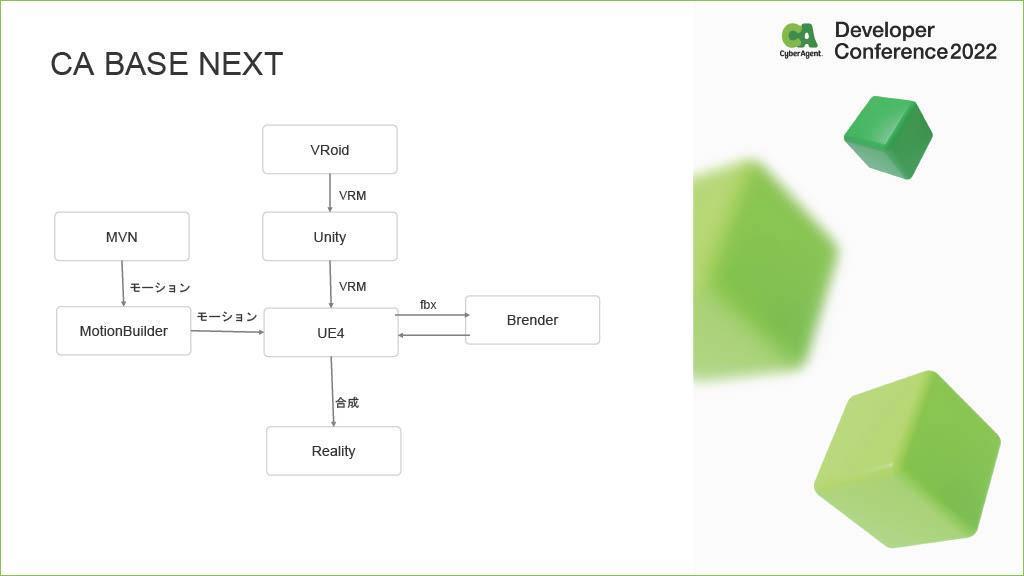

現場のモデルやモーションのフローは以下のスライドのように行っている。VRoidで作成したモデルをUnityでVRMとして調整、それをUnrealEngine4に持ち込み、Realityで合成する。Motionに関してはMVNを使い、MotionBuilderで調整してそのモーションをUE4にライブリンクでストリーミングする。モデル周りの調整などはBrenderなどで行っている。

苦労した点は、セルルックのキャラクターを現実世界で組み合わせることが挙げられた。フルCGでは可愛いキャラクターを現実世界の映像になじませるのは、非常に難しいと海木氏は言う。隣に立つリアルな人間と協調が取れるように、光の影響を強く受けられるようなPBRなシェーディングにした上で、印象的で派手なライティングを施すことで克服したという。

表情制御に関してはStreamDeckforAppを使い、現場ではiPhoneで行っていた。様々なトラブルにも対応しやすいボタン式も採用した。

一方で、表情制御を行うためフェイシャルキャプチャの使用も検討したものの、表現力が高い分演者負担が高い。また、当日の動きはオリジナルで事前に予想できないものが多かったため、結果としてはうまく作動できなかったと、海木氏は振り返る。

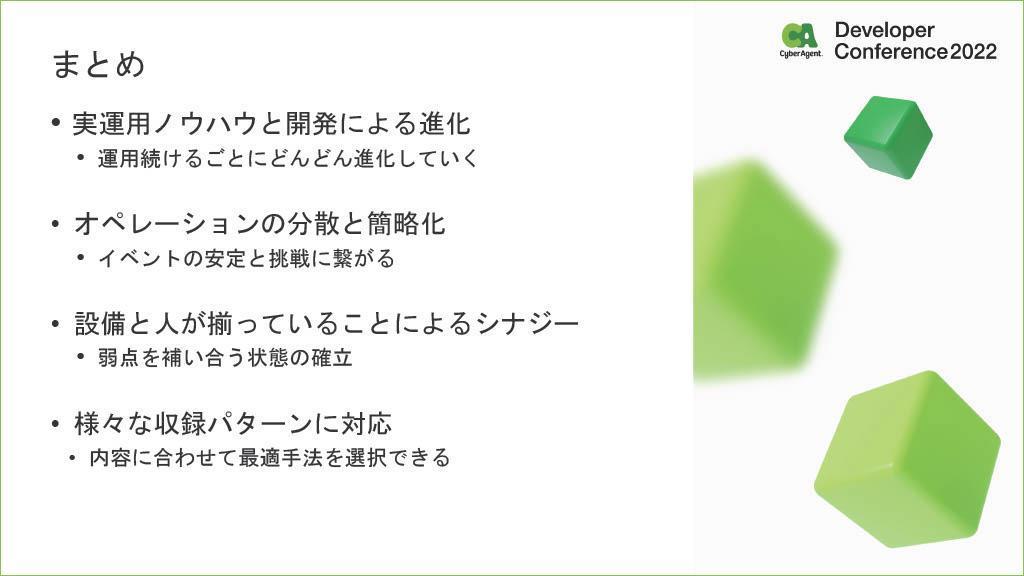

最後に海木氏は、運用ノウハウと開発の進化、オペレーションの分散と簡略化といった成果を出せたことや、設備と人がそろっていることによるシナジーや様々なパターンに対応できることを改めて強調し、セッションをまとめた。

セッション動画

文:馬場美由紀

関連記事

「欲しいけど難しい」IPづくり。群雄集うクリエイティブ集団「SSS by applibot」が実践する、IPを生み出すスクラップアンドビルドに密着

【Yahoo! JAPAN Tech Conference 2022】ヤフー・サイボウズ・ZOZOが語る、OSSへの貢献活動で得られたこと【イベントレポート】

17年間の技術負債にどう対処した? 負債の可視化からAWS全面移行まで、事業を支えてきたAmebaシステム刷新プロジェクトを振り返る

人気記事