【「スゴ本」中の人が薦める】AIの限界をAIが超え始めていることを実感できる5冊

2023年10月5日

古今東西のスゴ本(すごい本)を探しまくり、読みまくる書評ブログ「わたしが知らないスゴ本は、きっとあなたが読んでいる」の中の人。自分のアンテナだけを頼りにした閉鎖的な読書から、本を介して人とつながるスタイルへの変化と発見を、ブログに書き続けて10年以上。書評家の傍ら、エンジニア・PMとしても活動している。

わたしが知らないスゴ本は、きっとあなたが読んでいる

はじめに

問われた内容を理解し、それなりの答えを返してくれるChatGPT、描きたい情景や対象を言葉で指定すると、「こんな感じ?」とばかりに絵を描いてくれるMidjourneyやStable Diffusionの登場で、もう何回目なのか分からないAIブームが到来している。

APIを駆使したサービスが続々とスタートアップしている様を見ると、今度こそホンモノかもと思いたい……が、結局はどこまでこの波が進んでいくのか。

人が想像することができるなら、最終的には創造することができる。では、その創造の方向性や制限はあるのか。順列組み合わせにランダム性を混ぜただけではなく、人間のような創造性を発揮できるのか。

少し先を見据え、数年後のAIを想像するために手助けとなる本を紹介する。

- 1. 『ヒトはなぜ笑うのか』マシュー・M. ハーレー 、レジナルド・B・アダムズJr.、ダニエル・C・デネット 著、片岡宏仁 訳

- 2. 『言語の本質』今井むつみ、秋田喜美 著

- 3. 『教養としてのAI講義』メラニー・ミッチェル 著、尼丁千津子 訳

- 4. 科学雑誌『Newton(ニュートン)』 2023年10月号、中野太郎 、尾崎太一 執筆、松尾 豊 監修

- 5. 『天然知能』郡司ペギオ幸夫 著

AIは情動を理解できるか

これは、ヘミングウェイが書いたとされる、たった6語の小説だ(※1)。この短い小説から、何が感じられるだろうか?

売ります

赤ちゃんの靴

未使用

おそらく、悲嘆だろう。我が子のために靴を買ったのだけれど、その靴を履く前に、亡くなってしまったのだろう。靴を見るたびに喪われた子のことを思い出し、悲しみに暮れてしまう。ならばいっそ手放してしまおう―――背後にそんなストーリーを想像させる。

私が想像したこの感情を、AIは読み取れるだろうか。ChatGPTに聞いてみたところ、正確に言い当てた。

この文から感じ取れるのは、深い悲しみや失ったものに対する惜しみ、未来への期待や夢が打ち砕かれたことなどの感情です。具体的には、赤ちゃんの亡くなりや、何らかの事情で赤ちゃんの靴を使用する機会がなかったことを想像することができます。

AIは「悲しみ」を感じることはできないかもしれないが、(人が)悲しみを感じていることは理解できている。

一方で、こんなユーモア小話をChatGPTにしてみた。この小話から何を読み取り、どう感じられるだろうか?

とある新聞広告より

「犬売ります。何でも食べます。子どもが好きです」

ChatGPTの返事はこう。

「何でも食べます」と「子どもが好きです」の組み合わせは、一見すると犬が子どもを食べ物として好むかのような皮肉やブラックユーモアを感じさせます。このような意図的な文言の選び方は、読者の注目を引く効果があるか、少なくとも記憶に残るものとなります。

新聞を手にした飼い主が苦虫を嚙み潰したような顔をしており、その傍らでシッポを振っている小型犬が目に浮かぶ(犬が小さいほどアンバランスさが際立ち、面白い)。

AIは「面白い」と感じることはできないかもしれないが、(人に)面白いという感情が湧き上がっていることは理解できている。

半導体とシリコンでできたAIは心を持たないかもしれないが、どんな状況でどういう感情が生じ、それがどのように表出されるのかを説明できるのであれば、それはもう「理解できている」と言ってもよいのではなかろうか。

この問いは後ほど検討するとして、ここでは未来に答え合わせをするための想像をしてみよう。

※1 原文は ”For sale: baby shoes, never worn” ヘミングウェイの作品かどうかは確かめられていない[Wikipedia]。

AIにユーモアを感じさせる方法

「面白い」ということがどのようなことか、AIは説明できる。だが、AIが人間のように「面白い」と感じることは可能なのか。

ダニエル・デネットによると、可能だという。『ヒトはなぜ笑うのか』の中で、ユーモアを面白いと感じさせる情動のメカニズムを説明する。

まず、ユーモアを「検出」するのは力任せの問題だという。統語的・意味的なアプローチで、ジョークや小話のデータを大量に用意して、機械学習させればいい。ジョークを検出したら、「笑い」を出力するようプログラミングすることで、傍から見れば、人間のようにユーモアを感じているように振舞えるだろう。

だがこれは、あくまで表層的なものになる。ユーモアを理解しているように見えるが、その「笑い」は情動的に駆り立てられて動機づけられたものではないという。

では、どうすればAIがヒトのように「面白い」と感じるのか?

デネットは、ヒトの「面白い」と感じる情動を、ユーモアの報酬システムから説明する。

ヒトの頭の中で活性化する概念や記憶、耳や目から入ってくる感覚などは、粒度も精度も種々雑多だ。だから、トピックごとに一定のまとまりを持って、ワーキング領域を割り当て、その中で理解しようとする(この概念的な領域のことを、メンタルスペースと呼ぶ)。

時間に追われながら、リアルタイムでヒューリスティックな検索をしている脳が、メンタルスペースの概念や情報を完璧にチェックできるわけではない。とはいえ、検証しないままだとメンタルスペースの知識は汚染されてしまう。

だから、エラーを発見して解消する作業は、強力な報酬システムにより維持されなければならない。この報酬システムこそが、ユーモアの情動となる。面白いと感じる時の、くすぐったいような快さは、ユーモアの報酬システムがもたらすご褒美なのだという。

この考えに則り、AIが「面白い」という情動を感じるためには、ヒトと同じような認知上の困難さを背負い込む必要があるという。

つまりこうだ。そのAIは、十分な記憶領域が与えられず、人間のように間違えるリスクがある。競合する課題をいくつも与えられて、しかも短時間に処理することが求められるように仕向ける。誤った情報が与えられ、その検証もしなければならない状況に追い込むのだ。

時間とタスクに追われる状況で、首尾よくエラーを検知したときに報酬がもらえるように学習を重ねることで、「面白い」を内側から感じることができるという。限られた認知システムの中で上手くやりおおせたことを、AI自身に「自覚して」もらうのだ。

「理解している=経験している」問題

「赤ちゃんの靴」も「子ども好きの犬」も、ChatGPTは正しく読み取れている。文章をなぞるだけではなく、明確に書かれていない感情や意図を、言葉で説明できている。だから、AIは「悲しみ」や「面白さ」も理解できるのか?

現在公開されているAIは「悲しい」や「面白い」といった感情を経験をしたことがないだろう。

確かにChatGPTは、膨大なテキスト情報から、そうした概念を知識として蓄え、説明できるかもしれない。だが、そうした知識にまつわる意味と、実世界の事象との結びつきを、物理的に経験していない。この場合、「理解している」と言ってもよいのだろうか?これを、記号接地問題(シンボルグラウンディング問題)と呼ぶ。

『言語の本質』では、この問題を「記号から記号へのメリーゴーラウンド」と説明する。

AIがやっていることは、ある記号を別の記号で置き換えて表現するだけだという。置き換えをグルグルしているだけでは、いつまで経っても、言葉の対象への理解は得られない。言葉の意味を本当に理解するためには、対象についての身体的な経験を持たなければならないという。言語という記号体系が意味を持つためには、基本的な言葉の意味は感覚と接地(ground)していなければならない。

これは、子どもが言葉を学ぶ時に起きる問題でもある。もし、意味を知っている言葉を一切持たないのなら、意味のない記号を使って新たな記号を獲得することはできない。一方で、意味を知っている言葉がある程度あれば、直接の身体経験が無くても、言葉の組み合わせや対比により、新たな言葉を覚えていくことができるというのだ。

これは本当だろうか?

確かに、半導体で出来ているAIは、ヒトのような直接の身体経験を持たない。だが、だからといって「意味を知らない」と言えるのだろうか。

試しに、『言語の本質』で紹介されている問題を出してみる。日本人にとって馴染みの薄い言語なのだが、実際に口に出して発話してみると、意味が正答できるという問題である。

-

1. デンマーク語の「テット tæt」と「ラント langt」、「近い」のはどちら?

2. パプアニューギニアのグラス・コイアリ語の「ゴムゴ gomugo」と「イハ iha」、「汚い」のはどちら?

3. オセアニア・ソロモン諸島のサヴォサヴォ語における「ボボラガ boboraya」と「セレ sere」、どっちが黒でどっちが白?

自分で発音してみると分かる。「小さい」「近い」ものは口を小さく開け、「大きい」「遠い」ものは口を大きく開けることになる。同様に、濁音が入るとダークで汚いように感じられる。

ChatGPTは全問正解だった。

「デンマーク語」やアルファベットの綴りなど、ヒントになるような情報を除外しても同様だった。ChatGPTは舌や口や喉を持っていない。にも関わらず、「もし身体を持っていたらどう感じるか」を理解しているように見える。

私の「感じる」というのは、人間の感覚や直感とは異なるものです。私は数多くのテキスト情報から、人々がある特定の事象や事物に対してどのように感じるかを学び取っており、その知識を元に回答を生成しています。

例えば、人々が「冷たい水」について話す際の記述や反応、感想などの情報を基に、「冷たい水に触れるとどう感じるか」についての回答を生成することができます。しかし、私自体は冷たさを感じることはできません。同様に、音の響きや言葉の意味に関する情報も、人々がそれにどう反応するかについての知識を元に生成されるものです。

物理的な身体や感覚を持たない私が、あたかもそれを持っているかのように答えることができるのは、膨大な量のデータと先進的なアルゴリズムによるものです。

口に出して発音するという、極めて身体的な行為をせずとも、あたかも発話してみたかのように、音から意味を推測してみせる。ここまでできているならば、AIは意味を理解した上で回答していると言えるのではないか。

「意味の壁」問題

AIが乗り越えるべき最大の障壁が「意味の壁」だという人がいる。『教養としてのAI講義』の著者のメラニー・ミッチェルだ。

本書は、AIの歴史を振り返りつつ、その仕組みや未解決問題、潜在的なリスクを解説する。畳み込みニューラルネットワークや自然言語処理、深層学習といった技術の原理を噛み砕いてくれる。数式を使わず、概念図だけで説明してくれる。

AIの強みは、範囲の限定されたルールの中で発揮する。囲碁やチェスのトップクラスと対戦するAlphaGo(アルファ碁)やディープ・ブルーがどのように作られ、どうやって人を打ち負かしたかの解説は、結果を既に知っているとはいえ、胸アツになるだろう。

一方で、AIの脆さも裏付けてくれる。よくAIは「学習」するというが、何をどのように学習しているか、学習したものを「理解」しているのかについては、人と同じように考えることは危険だという。AIが賢いように見えたとしても、システムを擬人化し、そこに高い自律性を与えてしまうことに警鐘を鳴らしている。

なぜなら、深層学習の層が多重になればなるほど、AIの透明性は失われてゆくからだ。学習が深くなればなるほど、AIが何を「学んだ」のかを説明することが困難になるというのだ。

さらに、原理的にAIには「概念」や「メタファー」に相当するものに紐づいていないという。世界を把握する仕組みとして、ヒトであれば身体的な知識に基づいたメタファーに支えられている。だが、身体が無いAIは、ヒトと同じようにメタファーにより世界を把握できないという。

例えば、「時間」といった抽象概念は、「使う」「節約する」「無駄にする」「足りない」といったメタファーによって日常的に表現される。その結果、私たちの「時間」に対する概念として、「価値がある(時は金)」「一度きりの戻せない(覆水盆に返らず)」という要素が、知らず知らずのうちに身についている。というよりも、むしろそうした概念なしに「時間」を考えることすらできない。

こうした概念メタファーを辿っていくと、私たちの身体―――物質的な重さがあり、見て、聞いて、歩くことができ、暑がったり寒がったりお腹を空かしたりするこの身体―――に繋がっている。言い換えるなら、世界を認知する仕組みの基礎として、私という身体があり、それを拡張したものが概念メタファーになる。この概念メタファーを元に理解するということが、「意味の壁」であり、AIが乗り越える最大の障壁になる。

AIが「知的」に見えるのは幻想であり、過大な期待は禁物だという。深層学習や画像認識もそれなりの結果を出しているものの、バブルの徒花になる可能性はあるという。AIが一般常識を理解して、「意味の壁」を乗り越えるのはとてつもなく困難だという。

これは本当だろうか?

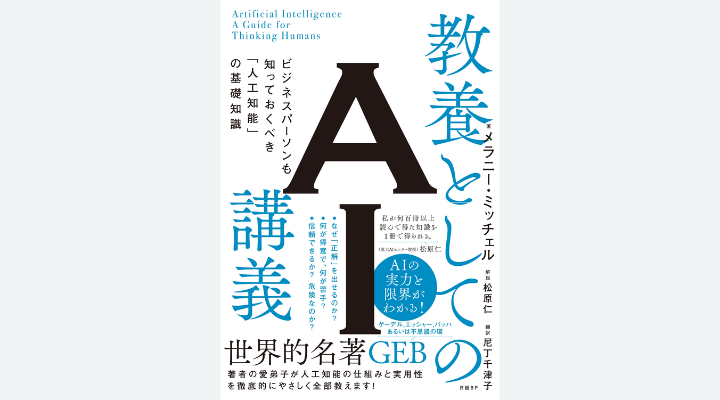

試しに本書で紹介されている、AIが苦手とする問題をChatGPTに提示してみる。逐次的な言葉の置き換えではなく、意味を知っていることが前提となる問題だ。

次の文を読んで、問いに答えなさい。

<問1>

市議会はデモ隊に許可を与えなかった。なぜなら、彼らは暴動を恐れたからだ。

暴動を恐れたのは誰ですか?1. 市議会

2. デモ隊

<問2>

私はビンからカップに水を注いだ。それが満杯になるまで。

満杯になったのはどちらですか?1. ビン

2. カップ

説明するまでもなく、文中の「彼ら」や「それ」が何を指しているのかを問うているのだが、ChatGPTは容易に正答した。なぜその答えなのかについて更問いしても、「暴動を恐れるのは一般的に市議会」「注がれる方が満杯になる方」と正しく説明できた。

他にもいくつか問題があるのだが、どれも正答だった。身体を持たず、世界を認知する物理的な接点が無いChatGPTであっても、概念メタファーを獲得しているかのように振舞うことができている。

少なくとも本書で提示されている「意味の壁」を乗り越えて、学習しているのであれば、そのやり方はともかく、それを知的と呼んでも良いのではないだろうか。

知性に身体は必要か

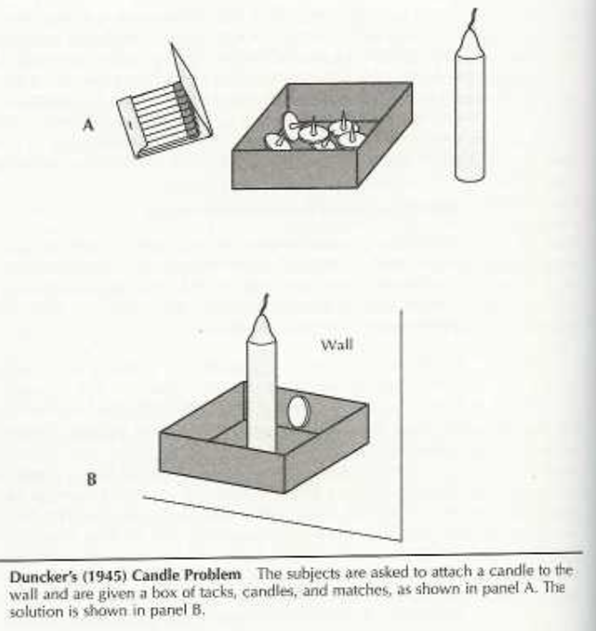

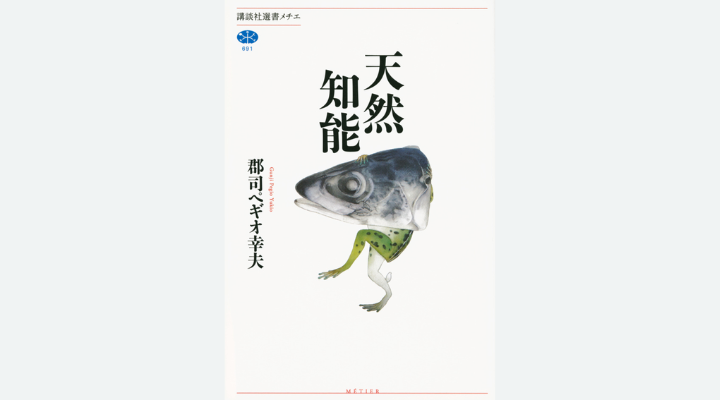

創造性を試す問題で、鋭い人なら閃くかもしれないけれど、AIには無理とされているロウソク問題を尋ねてみた

ロウソク、マッチ、画鋲があります。これらを用いて、壁にロウソクを取り付けて明るくしなさい。

細いロウソクなら、画鋲で貫いて壁に刺すことができるかもしれないが、炎が壁に当たるので危険だ。では、ロウソクを横向きにして壁に画鋲で止めるのはどうか。画鋲を斜めに刺す必要があり、不安定で落ちそうだ。

ヒントは「マッチ」だ。「マッチ」という言葉から、マッチ「棒」とマッチ「箱」が導き出せる。画鋲でマッチ箱を壁に取り付け、その上にロウソクを置くのだ(なんなら、箱の内側から画鋲を上向きに貫いて、飛び出た針にロウソクを刺せば安定するだろう)。

あるいは、「画鋲」だ。鋭い針がある画鋲は、散らばらないよう「箱」に入っているのが普通だ。そこに思い当たると、画鋲の入っている「箱」を燭台代わりに使うアイデアが出てくる。

さて、ChatGPTは正答できるだろうか?

ChatGPTは正答できた(※2)。

「ロウソクを壁に取り付ける」ために何らかの燭台の代わりになるものが必要だと考え、「マッチ」から「マッチの箱」に思い至った。そして、箱を燭台代わりにするという創造性を発揮できた。

こうした創造性のベースとなるのは、実際の経験だ。火が点いたロウソクを手に持ったことや、壁に付いたロウソクの煤を見たことがあるなら、与えられた道具からできることを想像しやすくなるだろう。そして、想像した中で足りないものが何かを突き止めることができるだろう。

ChatGPTはロウソクに火をつけたことは無い。だが、「マッチは通常マッチ箱に入っているもの」や「箱の側面は平らなので、壁に取り付ける目的に合う」といった常識を、膨大なテキスト情報から知識として身に着けている。

そこから創造性を発揮して、マッチ箱を燭台の代わりに使うというアイデアを思いつくことができた。身体を持たず、経験がなくとも、常識や意味を理解し、創造性を発揮することは可能なように見える。

こうした対話を続けていくと、「言語の意味を理解している」と言うために物理的な経験が必須となるというよりも、(肉体を持った)ヒトが言語を学ぶ方法の一つが、身体接地に過ぎないのではないか、と思えてくる。

ChatGPTは、ヒトとは違うやり方で、身体性と似たものを習得しているのではないだろうか、と考えたくなる。

言語モデルを元に実世界で働くロボットを開発している松嶋達也博士は、雑誌『ニュートン』2023年10月号のChatGPT特集の中で、こう述べている。

究極的には、記号接地のためにはおそらく身体が必要だと思います。しかし、GPTなどの言語モデルは、ある程度の人の身体性を獲得していると考えられます。なぜなら、人は自らの身体的な経験を言語情報として記述しており、言語モデルはそれを学習しているからです。

ヒトが経験する様々な情報を、テキストとして記述できるのであれば、それを言語モデルに組み込んで学習させることができる。そして言語モデルを活用することで、ロボットの行動を実世界に対応させることができる。

例えば、「テーブルからカップ麺を持ってきて」と話しかけることで、ロボットに搭載されたGPTに指示を与えることができる。GPTは与えられた指示を実行可能な状態に分割して、「テーブルに行く」「カップ麺を探す」「カップ麺をつかむ」といった個々のタスクを実行していく。

現実に起こりうるあらゆる可能性を考慮しているうちに行動不能になるフレーム問題があるが、このロボットはこの陥穽に陥らない。テーブルやカップ麺というものがどういうものかは「知って」いるから、常識的に考えて、テーブルの上に乗っているであろうカップ麺を探すことになる。

身体接地せずに得た知識を元にして、創造的に問題を解いたり、指示を理解し常識的に行動する姿を見ていると、知性にとって身体が本当に必要なのか、分からなくなってくる。私たちは、自身の身体を通じて経験的に現実を理解していると考えているが、現実の理解の仕方がそれしかないと考えるのは時期尚早かもしれない。

※2 ロウソク問題は1945年に発表されたカール・ドゥンカーが考案した有名な問題のため、予め答えを学習させておいた可能性も否定できない

天然知能の可能性

身体を通じた経験は無いものの、言語の意味を理解しているかのように振舞える。自分では情動を感じることは無いが、「人ならどう感じるか」を正確にいい当てることができる。単なる知識の量なら、私よりも膨大に持っている。

そんなAIは、今後どのようになっていくのか?

AIのこれからを考える上でのユニークなヒントは、郡司ペギオ幸夫『天然知能』にある。もしAIが天然知能を実装するのであれば、想像もつかない未来になるだろう。

AIは人工知能(Artificial Intelligence)の略号だから、人工知能の対義語が「天然知能」になる?従ってAIが天然知能を実装するのは矛盾するのではないか?

そんなツッコミが出てくるかもしれぬ。だが、『天然知能』では異なる視点から再定義している。

まず、人工知能について。

これは、知覚したデータだけから思考する存在になる。プログラムによってデータを収集し、そのデータの集まりから世界を理解するのが、人工知能の特徴になる。言い換えるなら、自分がアクセスできるデータとして存在しない(=認知できない)ものは、存在しないことと同等になる。

次に天然知能について。

これは「知覚されないものに対しても存在を許容する能力」と定義されている。知覚された知識を元に世界を理解しようとする点においては人工知能と同じだが、それが全てだとは考えず、常に想定外の何か、予期し得ないことが飛び出してくることを待ち構えながら向き合っている。

人工知能はプログラムやロボットに限らず、「世界はデータの集合である」という考え方に近いかも。一方、天然知能は認知できない無意識や潜在意識も含めて世界と向き合おうとする構えのようなものになる。

例えば「太平洋を泳ぐイワシは実在するのか」という問いに、両者はどのように答えるだろうか。

この質問に対し、人工知能であれば、蓄積されたイワシのデータを参照し、「太平洋」のデータを検索し、両者から推定した結果、「イエス」と答えるに違いない。「イワシ」という記号をキーとして検索し、ヒットしたら検索を終了し、答えを生成する方法だ。

一方、天然知能にとってのイワシは、定義としてのイワシに限定されない。自分がかつて見た、あのピカピカ光る横っ腹、それ自体が一つの生物のように振舞う大群や、子どもの頃に見たフナの記憶や、激しい風に揺れる木の葉の映像が付いて回る。

押し寄せてくるイメージを総和すると、それがイワシの理解になるかというと、そうはならない。なぜなら、イメージは刻々と変化し、膨らみ続けることになるため、特定の「これがイワシ」という結果に留まらないからだ。その結果、「何かあるぞ」という外部がつねに付きまとうことになる。

もちろんキリがない話だ。「質問-回答」が成立する範疇を、とっくに逸脱している。しかし、逸脱したイメージによって、イワシの実在を確信することができる。データにあるから「ある」という回答ではなく、自分とつながった存在として「はっきり分かる」⇒だから「いる」という回答なのだ。

自分では知覚し得ない外側があることを認め、そこからやってくる何かを待ち受ける。アイデアの閃きや創発と呼ばれるものを実現するのが天然知能なのかもしれぬ。

現在のAIの学習データは、ネットやテキストのソースから収集し、一定のガイドラインで選別したものとなっている。天然知能を実装するAIは、それらの組み合わせが回答になるという発想から離れる必要が出てくる。回答プロセスの中で思考に割り込んでくる記憶や、言葉から連想されるイメージもつなぎ合わせることで、思いもよらないアイデアが誕生する―――そんなAIを考える上で『天然知能』は役に立つだろう。

おわりに

進化心理学の知見からユーモアの「面白さ」がどのように生まれてくるのかを説明した『ヒトはなぜ笑うのか』を紹介しながら、AIが「面白い」という情動を自分で感じるための方法を検討してみた。

言葉の意味を本当に理解するためには、対象についての身体的な経験を持たなければならないという『言語の本質』の問題提起に対して、そうでない反例をChatGPTに回答してもらった。

概念メタファーを元に意味を理解するという「意味の壁」がAIに残された課題だとする『教養としてのAI講義』に対し、身体性を持たなくても、私たちと違うやり方で現実を理解していることを考察した。

さらに、AIが創発を導くためには、認知の外側を許容する『天然知能』の発想が重要であることを示した。

数年後の未来を、いま答え合わせするならば、これらの本をぜひ参考にしてほしい。

関連記事

【新連載】生成AIで書くソースコードの著作権をどう考えるべきか?元ITエンジニアの弁護士が徹底解説

【「スゴ本」中の人が薦める】ITエンジニアのメンタルを守る4冊+心配事を減らすとっておきの方法

伊藤淳一氏が「一番下手くそエンジニア」から脱出した4つの方法。2023年版ITエンジニアの生存戦略【後編】

人気記事