何かに隠れても長時間正確に追跡可能。映像内の物体の動きの軌跡をピクセル単位で追跡する手法「OmniMotion」【研究紹介】

2023年6月21日

先端テクノロジーの研究を論文ベースで記事にするWebメディア「Seamless/シームレス」を運営。最新の研究情報をX(@shiropen2)にて更新中。

米カーネギーメロン大学、米Google Research、米UC Berkeleyに所属する研究者らが発表した論文「Tracking Everything Everywhere All at Once」は、動画内の物体におけるピクセル間の運動軌跡を追跡するモーション推定を提案した研究報告である。

物体が動いた軌跡を高密度で長時間追跡できるのに加え、前景の物体に隠れても正確に追跡できる。またカメラの移動やズームなどによって物体の見え方が変わっても一貫性を保った追跡が行える。

研究背景

モーション推定とは、コンピュータビジョンにおける基本的なタスクであり、ビデオシーケンス内の物体やカメラの動きを追跡することを指す。映像解析、物体追跡、3D再構成、視覚効果など様々な用途で重要な役割を担っている。

モーション推定の手法は、従来、スパース特徴追跡と密なオプティカルフローという2つの主要なアプローチのいずれかに従ってきた。各タイプの手法はそれぞれの用途に有効であることが証明されているが、どちらの手法も欠点を持っており完全とは言えない。

スパース特徴追跡は、キーポイントのような特徴点の追跡だけで全ての画素の動きをモデル化できない。密なオプティカルフローは、全ての画素の動きを捉えるが、長時間やオクルージョン(手前の物体に回り込み奥の物体の一部もしくは全部が隠れている状態)になると性能が低下する。

このギャップを解消するために、映像中の高密度な画素と長距離の画素の軌跡を推定するアプローチが数多く提案されている。しかし、長いシーケンスを正確に追跡する、オクルージョンを通してポイントを追跡する、空間と時間における一貫性を維持する、という3つの重要な課題があり、これらの課題を全て解決した手法は依然として存在しない。

研究内容

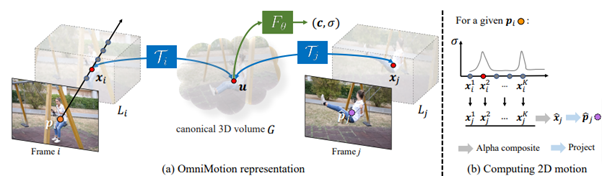

今回の研究では、これらの課題を解決するために、映像中のすべての画素の長時間の運動軌跡を推定する、新しいモーション推定手法「OmniMotion」を提案する。この手法は、長時間の追跡を可能にし、オクルージョンでも頑強な追跡を行い、カメラ位置が変わっても一貫性を保った追跡を行う。

OmniMotionは、フレームの集合と対になったノイズの多いモーション推定値(オプティカルフローなど)を入力とし、これらを用いて、ビデオ全体のグローバルに一貫した運動表現を解き明かす。運動表現を取得するために、Canonical 3D volumeという時空間表現を中間に用いている。

Canonical 3D volumeには、NeRFから派生した座標ベースのネットワークがあり、各3次元座標を密度と色に対応付けしている。密度情報は、フレーム全体の表面位置を追跡し、物体がオクルージョンされているかどうかを判断するのに使う。色は、最適化を目的としたphotometric lossの計算を可能にする。これにより、あるフレームの3次元座標をCanonical 3D volumeに写像し、異なるフレームの3次元空間の同一ポイントに結びつけることができる。

実証実験

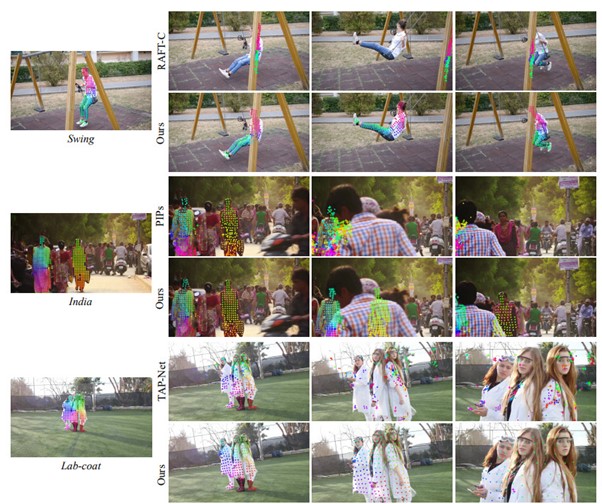

実験では、提案手法のモーション推定のパフォーマンスを評価するためにTAP-Vidベンチマークを作成した。TAP-Vidベンチマークは、人間によるモーション推定の正確なアノテーションを持つ実世界のビデオと、完全なグラウンドトゥルースのモーション推定を持つ合成ビデオから構成されている。

類似研究の最先端ベースラインと比較した結果、実世界のビデオと合成ビデオの両方において、提案手法が先行する最先端手法を大きく上回ることがわかった。特にオクルージョンが発生した場合や映像がズームされた場合において、提案手法だけは崩壊することなく正確な追跡が実行され、明らかな差が確認された。

提案手法の制限としては、これまでの手法と同様に、素早い動きや液体などの非剛体運動、薄い構造に対しては追跡が困難になることが挙げられる。また処理における計算量も多く、今後の課題としている。

Source and Image Credits: Wang, Qianqian, et al. “Tracking Everything Everywhere All at Once.” arXiv preprint arXiv:2306.05422 (2023).

人気記事